Capítulo 34 Regressão

34.1 Análise de regressão

34.1.1 O que é regressão?

Regressão refere-se a uma equação matemática que permite que uma ou mais variável(is) de desfecho (dependentes) seja(m) prevista(s) a partir de uma ou mais variável(is) independente(s). A regressão implica em uma direção de efeito, mas não garante causalidade.276

Para estimar os efeitos imparciais de um fator de exposição primária sobre uma variável de desfecho, frequentemente constroem-se modelos estatísticos de regressão.224

O pacote modelsummary308 fornece as funções modelsummary e modelplot para gerar tabelas e gráficos de coeficientes de regressão.

O pacote gtsummary215 fornece a função tbl_regression para construção da ‘Tabela 2’ com dados do modelo de regressão.

34.1.2 Quais são os algoritmos de regressão?

Linear: Simples, Múltipla, Polinomial.REF?

Linear generalizado: Binomial (logística), Multinomial, Ordinal, Poisson, Binomial negativa, Gama.REF?

Não-linear (nos parâmetros).REF?

Aditivo generalizado.REF?

Efeitos mistos: Linear, Generalizado.REF?

Sobrevida: Cox, Weibull, Exponencial, Log-normal, Log-logístico.REF?

Regularização: Ridge, LASSOREF?

34.2 Estruturas de análise de regressão

34.2.1 O que são análises de regressão simples?

A análise de regressão simples consiste em modelos estatísticos com uma variável dependente (desfecho) e uma variável independente (preditor).309

A equação de regressão simples é expressa como (34.1), onde \(Y\) é a variável dependente, \(X\) é a variável independente, \(\beta_0\) é o intercepto (constante), \(\beta_1\) é o coeficiente de regressão da variável independente e \(\epsilon\) representa o erro aleatório do modelo.309

\[\begin{equation} \tag{34.1} Y = \beta_0 + \beta_1 X + \epsilon \end{equation}\]

34.2.2 O que são análises de regressão multivariável?

A análise multivariável (ou múltiplo) consiste em modelos estatísticos com uma variável dependente (desfecho) e duas ou mais variáveis independentes.309

A equação de regressão multivariável é expressa como (34.2), onde \(Y\) é a variável dependente, \(X_1, X_2, ..., X_n\) são as variáveis independentes, \(\beta_0\) é o intercepto (constante), \(\beta_1, \beta_2, ..., \beta_n\) são os coeficientes de regressão das variáveis independentes e \(\epsilon\) representa o erro aleatório do modelo.309

\[\begin{equation} \tag{34.2} Y = \beta_0 + \beta_1 X_1 + \beta_2 X_2 + ... + \beta_n X_n + \epsilon \end{equation}\]

34.2.3 O que são análises de regressão multivariada?

A análise multivariada consiste em modelos estatísticos com duas ou mais variáveis dependente (desfechos) e duas ou mais variáveis independentes.309

A equação de regressão multivariada é expressa como (34.3), onde \(Y_1, Y_2, ..., Y_m\) são as variáveis dependentes, \(X_1, X_2, ..., X_n\) são as variáveis independentes, \(\beta_{0j}\) é o intercepto (constante) da variável dependente \(Y_j\), \(\beta_{ij}\) são os coeficientes de regressão das variáveis independentes para a variável dependente \(Y_j\) e \(\epsilon_j\) representa o erro aleatório do modelo para a variável dependente \(Y_j\).309

\[\begin{align} \tag{34.3} Y_1 &= \beta_{01} + \beta_{11} X_1 + \beta_{12} X_2 + \dots + \beta_{1n} X_n + \epsilon_1 \\ Y_2 &= \beta_{02} + \beta_{21} X_1 + \beta_{22} X_2 + \dots + \beta_{2n} X_n + \epsilon_2 \\ &\vdots \\ Y_m &= \beta_{0m} + \beta_{m1} X_1 + \beta_{m2} X_2 + \dots + \beta_{mn} X_n + \epsilon_m \end{align}\]

34.3 Tipos e famílias de regressão

34.3.1 O que são modelos de regressão linear?

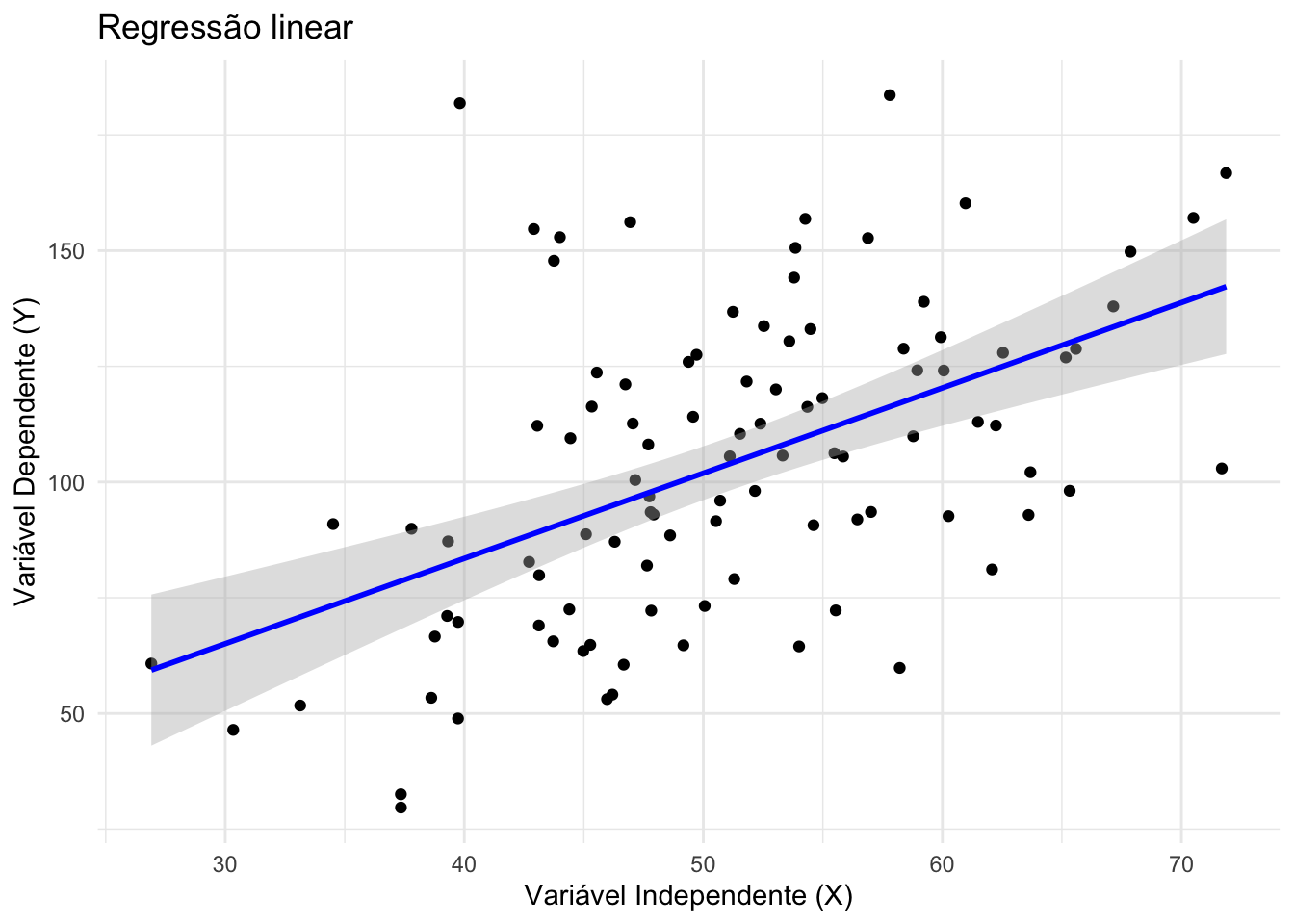

- Modelos lineares (34.4) descrevem uma relação linear nos parâmetros entre um desfecho contínuo \(Y\) e um ou mais preditores \(X\).REF?

\[\begin{equation} \tag{34.4} Y = \beta_0 + \sum_{i=1}^{n} \beta_i X_i + \epsilon \end{equation}\]

Assumem erros independentes, de média zero e variância constante (homocedasticidade).REF?

A normalidade dos resíduos é uma hipótese comum para inferência estatística, mas não obrigatória para estimação dos coeficientes.REF?

Figura 34.1: Regressão linear.

34.3.2 O que são modelos de regressão polinomial?

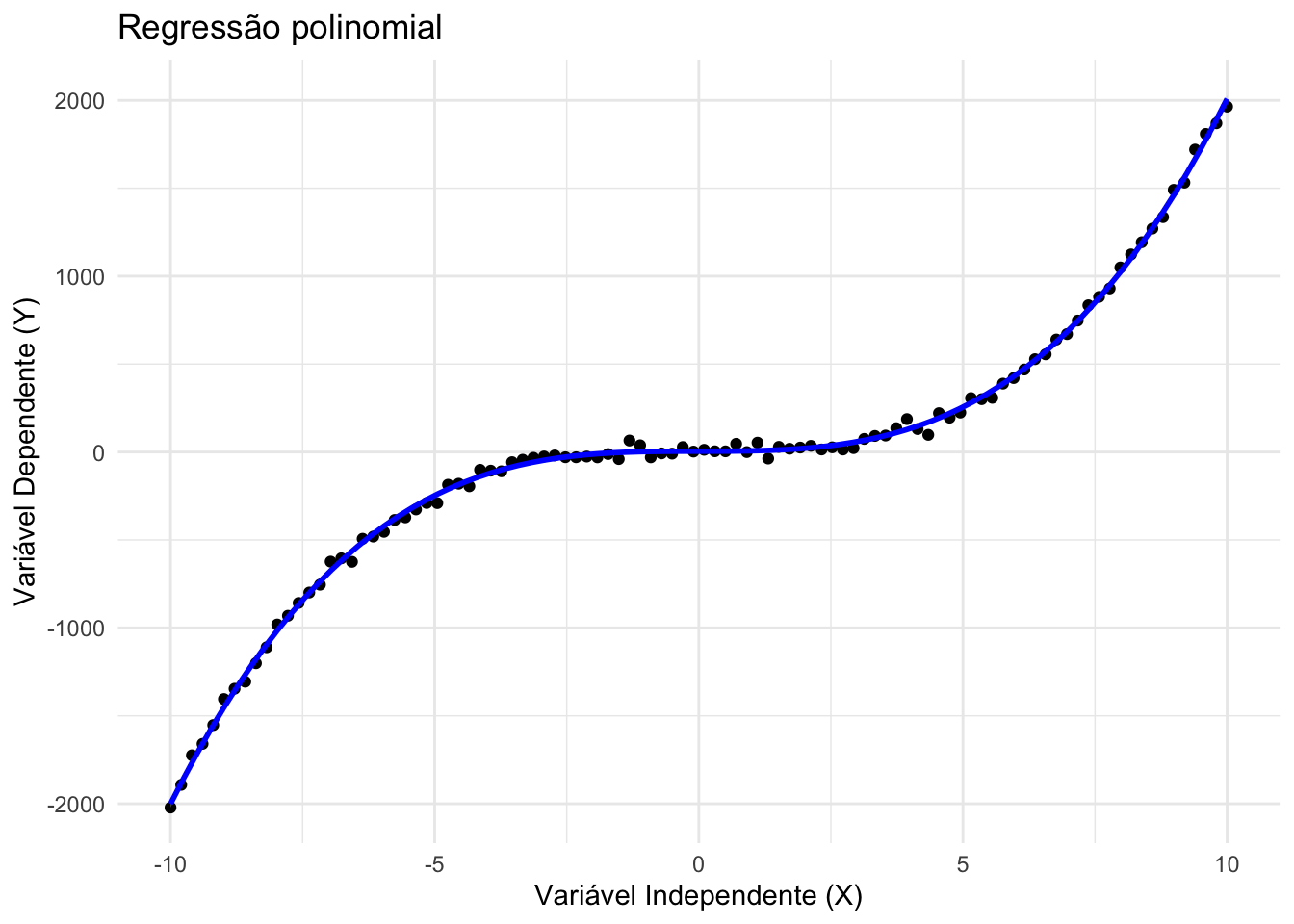

São extensões da regressão linear em que se incluem termos elevados a potências das variáveis independentes (ex.: \(X^2\), \(X^3\)), permitindo capturar relações curvas.REF?

Modelos de regressão polinomial continuam sendo lineares nos parâmetros, por isso ainda se enquadram como um caso particular da regressão linear.REF?

Figura 34.2: Regressão polinomial.

34.3.3 O que são modelos de regressão não-linear?

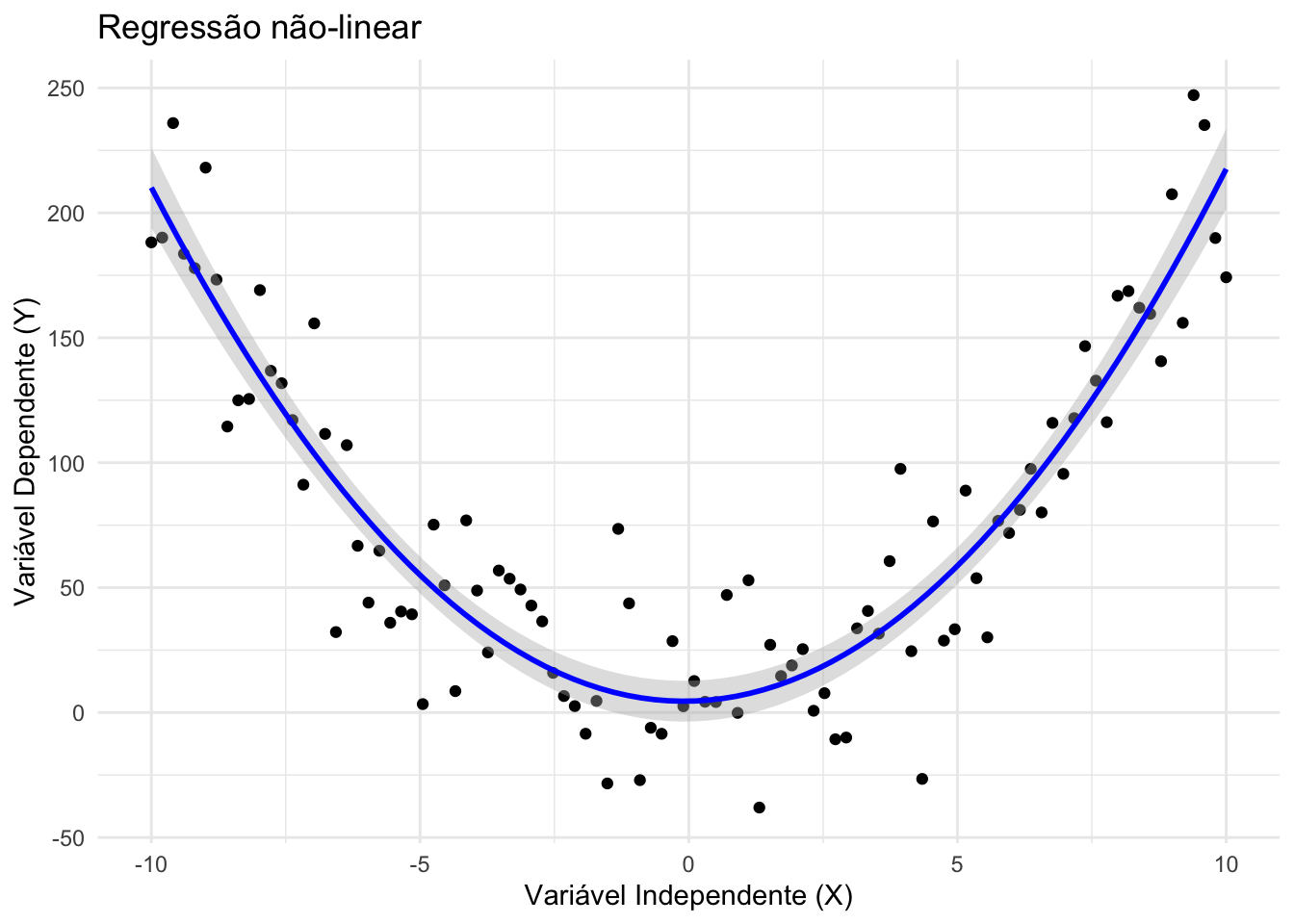

São modelos em que a relação entre os parâmetros e a variável resposta não é linear.

Podem assumir formas funcionais mais complexas (ex.: exponencial, logarítmica, logística).REF?

Importante diferenciar “não-linear na variável” (ex.: polinomial) de “não-linear no parâmetro” (ex.: modelos logísticos de crescimento).REF?

Figura 34.3: Regressão não-linear.

34.3.4 O que são modelos de regressão logística?

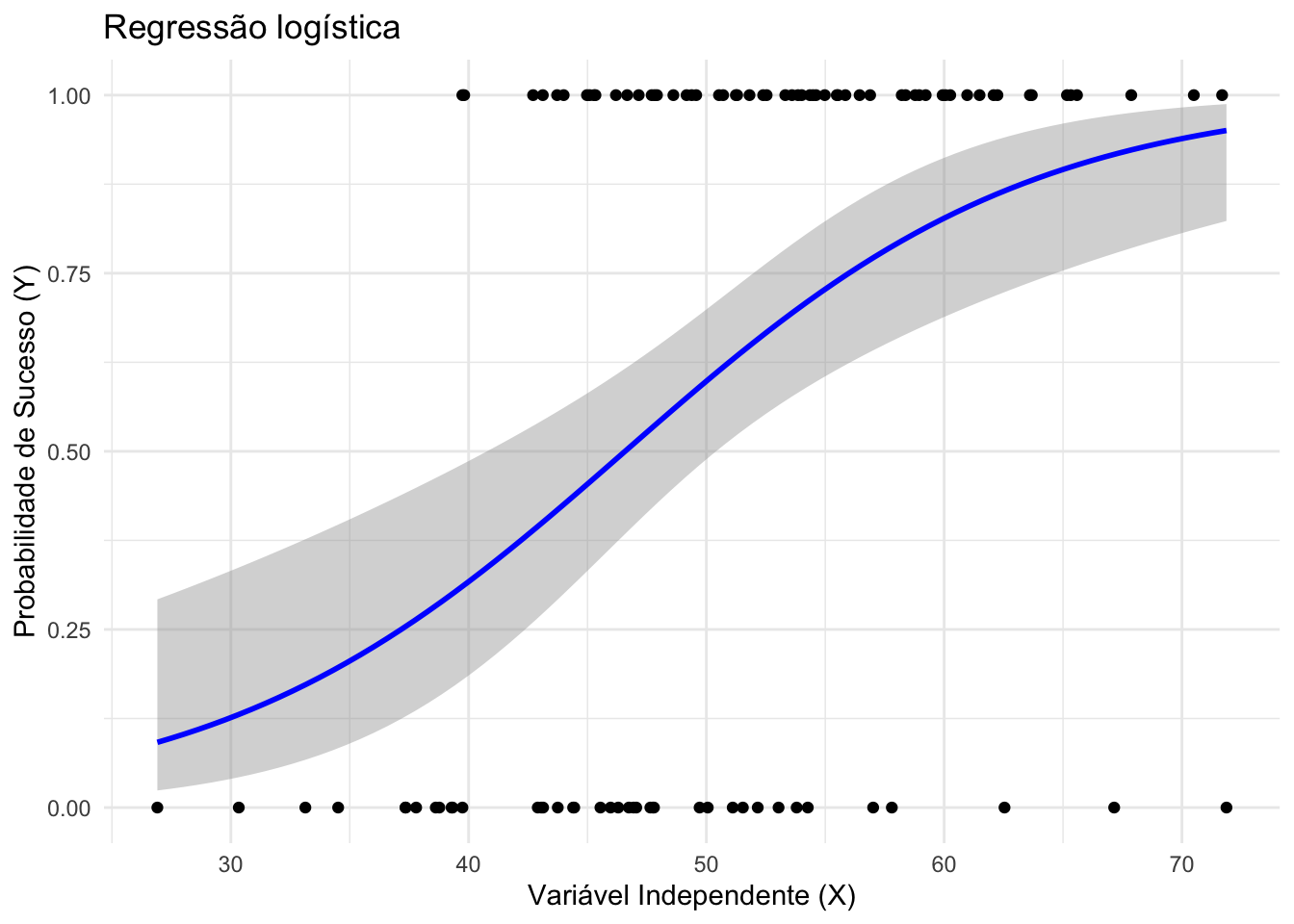

Modelos logísticos são casos de regressão linear generalizada em que a resposta \(Y\) é binária.310

A equação (34.5) modela a razão de chances (odds) em função dos preditores.310

\[\begin{equation} \tag{34.5} \log\left(\frac{p}{1-p}\right) = \beta_0 + \beta_1 X + ... + \beta_n X_n \end{equation}\]

\[\begin{equation} \tag{34.6} g(p) = \log\left(\frac{p}{1-p}\right) \end{equation}\]

A interpretação dos coeficientes \(\beta_i\) pode ser feita em termos de razões de chances (odds ratios, \(OR\)), por exponenciação dos coeficientes: \(OR_i = e^{\beta_i}\), o que representa o fator multiplicativo na \(OR\) do desfecho para cada aumento de uma unidade em \(X_i\) (mantendo os demais preditores constantes).310

A intepretação pode ser feita por estimativa da variação percentual na chance (\(OR\)) de ocorrência de \(Y\), calculando \((e^b - 1) \times 100\), de modo que um aumento de 1 unidade em \(X\) está associado a um aumento de \((e^b - 1) \times 100\%\) na chance de \(Y\) ocorrer (mantidos os demais preditores constantes).

Figura 34.4: Regressão logística.

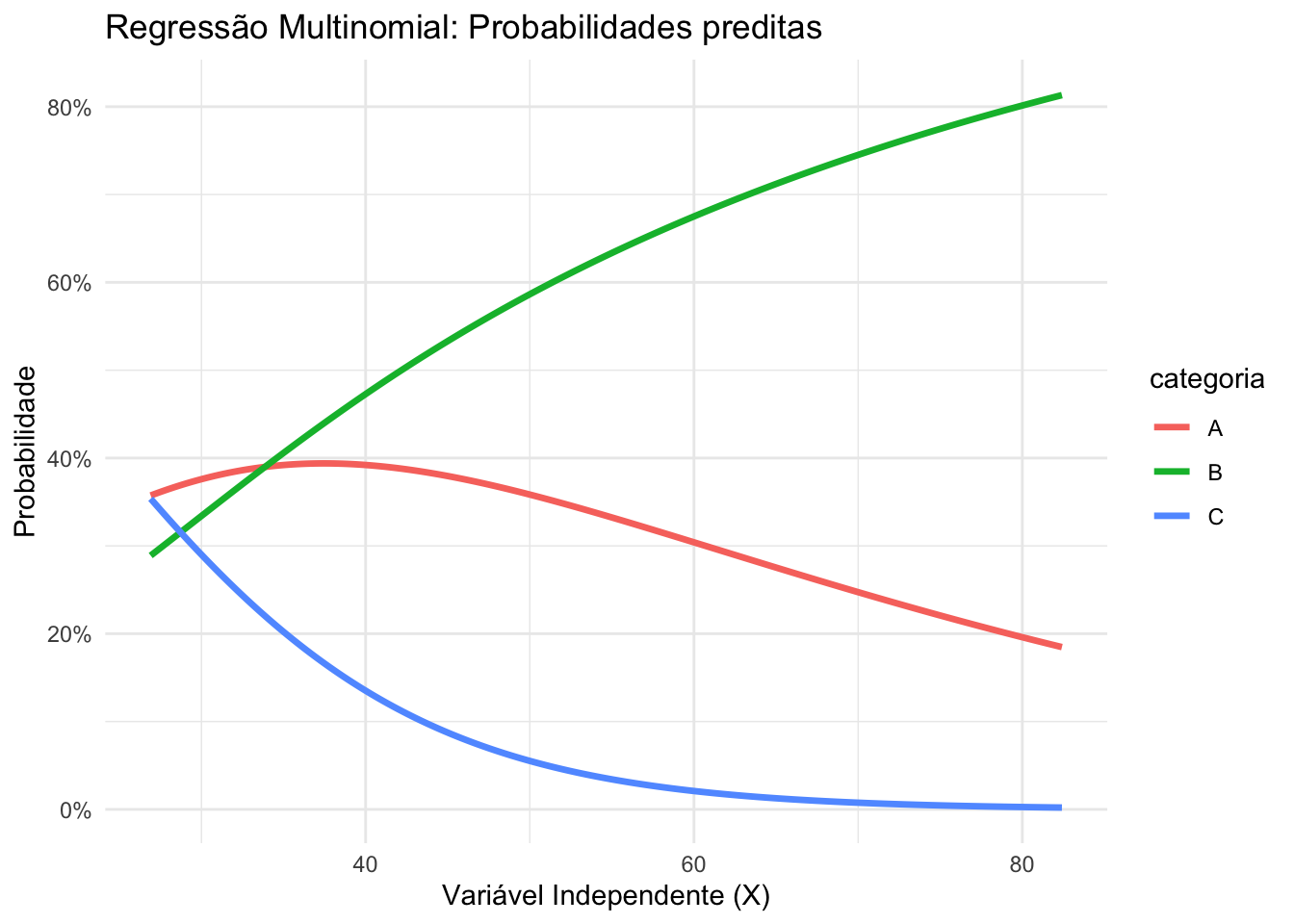

34.3.5 O que são modelos de regressão multinomial?

Modelos de regressão multinomial são usados quando a variável resposta é categórica com mais de dois níveis não ordenados.REF?

Estendem a regressão logística binária, modelando as razões de chances (odds ratios) de cada categoria em relação a uma categoria de referência.REF?

Figura 34.5: Regressão multinomial

34.3.6 O que são modelos de regressão ordinal?

Modelos de regressão ordinal são usados quando a variável resposta é categórica com mais de dois níveis ordenados.REF?

Modelam a probabilidade acumulada de estar em ou abaixo de cada categoria, usando uma função de ligação logit, probit ou log-log.REF?

Assumem a proporcionalidade dos coeficientes entre as categorias (proportional odds).REF?

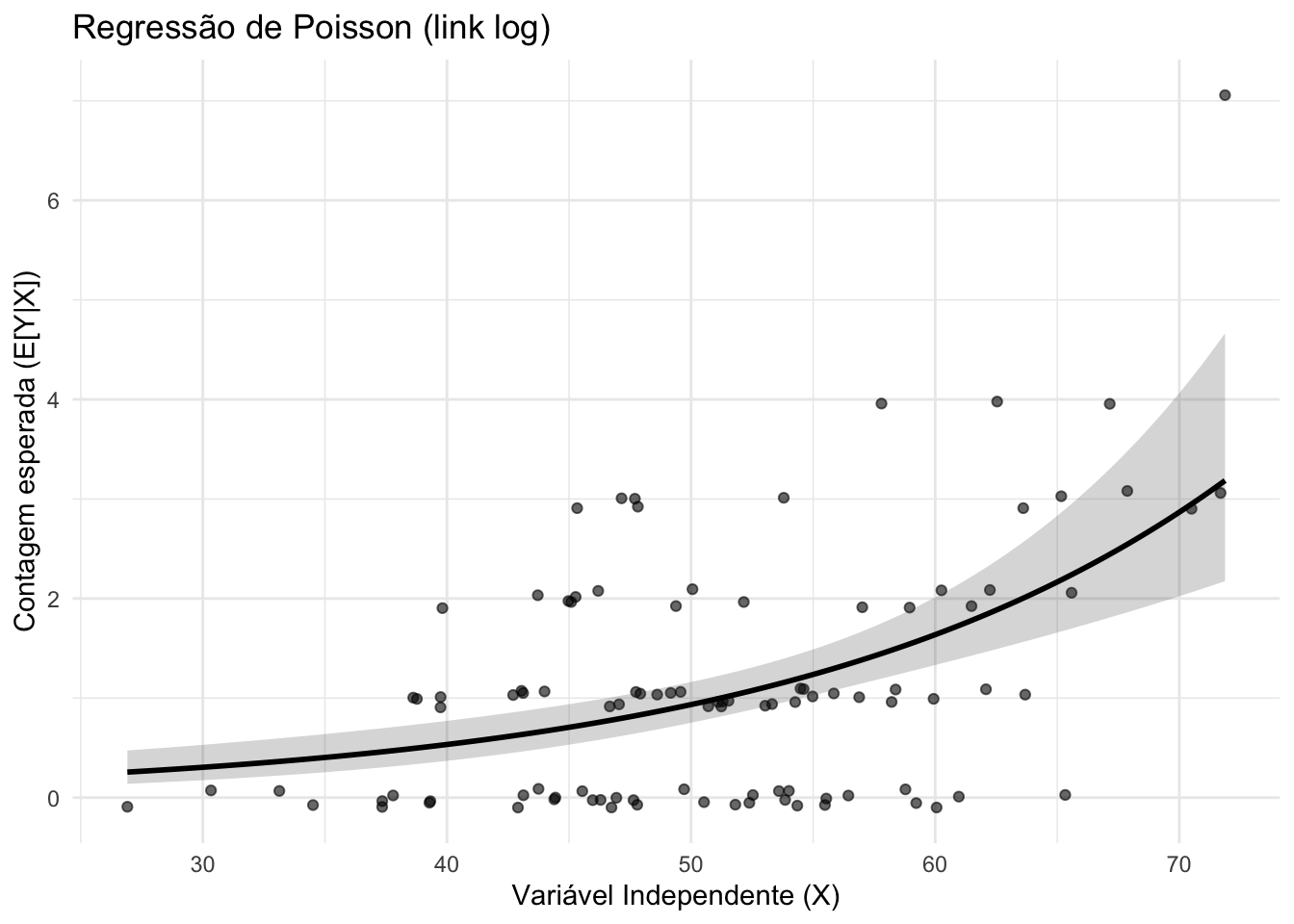

34.3.7 O que são modelos de regressão de Poisson?

Modelos de regressão de Poisson são usados quando a variável resposta é uma contagem de eventos não negativos.REF?

Assumem que \(Y \sim Poisson(\mu)\), com \(\mu = E[Y|X]\) relacionado aos preditores via função de ligação log.REF?

A sobre-dispersão (variância maior que a média) pode exigir modelos alternativos como a regressão binomial negativa.REF?

Figura 34.6: Regressão de Poisson.

34.3.8 O que são modelos de regressão binomial negativa?

Modelos de regressão binomial negativa são usados para contagens superdispersas, onde a variância excede a média.REF?

Introduzem um parâmetro de dispersão adicional para modelar a variabilidade extra.REF?

A função de ligação log é comumente usada, semelhante à regressão de Poisson.REF?

34.3.9 O que são modelos de regressão Gama?

Modelos de regressão Gama são usados para variáveis resposta contínuas e positivas, frequentemente com distribuição assimétrica.REF?

A função de ligação log é comumente usada para garantir predições positivas.REF?

34.3.10 O que são modelos de regressão com efeitos mistos?

Modelos de efeitos mistos incorporam efeitos fixos (coeficientes comuns a todos os indivíduos) e efeitos aleatórios (variações específicas de grupos ou indivíduos).REF?

Usados para dados hierárquicos ou longitudinais, onde observações estão agrupadas.REF?

Permitem modelar correlações intra-grupo e variabilidade entre grupos.REF?

34.3.11 O que são modelos de regressão com efeitos mistos generalizados?

Modelos de efeitos mistos generalizados (GLMM) estendem os modelos de efeitos mistos para variáveis resposta que seguem distribuições da família exponencial (ex.: binomial, Poisson).REF?

Combinam a flexibilidade dos modelos lineares generalizados com a capacidade de modelar correlações e variabilidade entre grupos.REF?

Usados para dados hierárquicos ou longitudinais com desfechos não normais.REF?

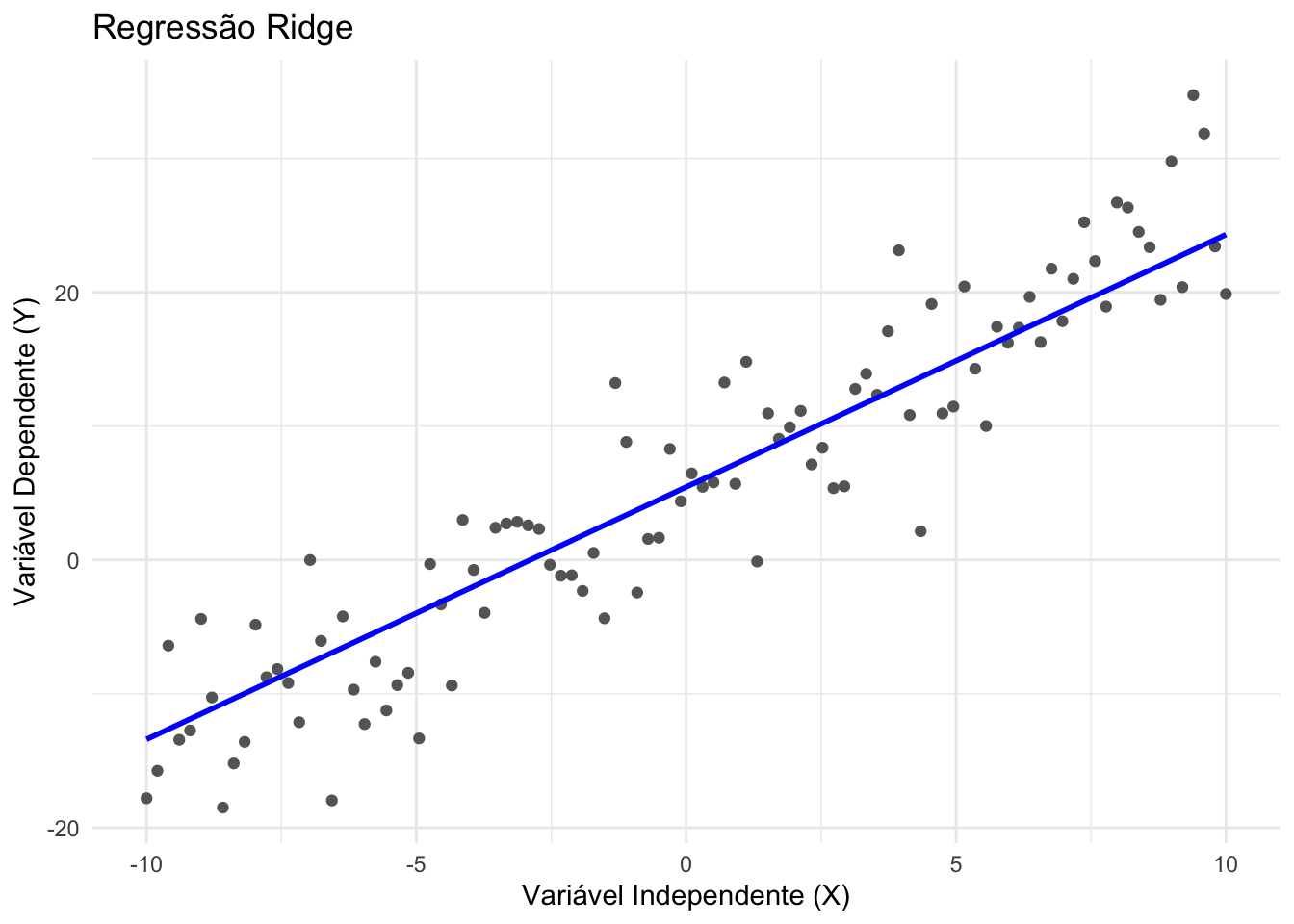

34.3.12 O que são modelos de regressão ridge?

Regressão ridge é um modelo linear regularizado que adiciona uma penalização L2 à soma dos quadrados dos coeficientes.REF?

Ajuda a reduzir multicolinearidade e overfitting, encolhendo os coeficientes em direção a zero, mas nunca os tornando exatamente nulos.REF?

O hiperparâmetro de regularização é \(\lambda\), controlando a intensidade da penalização. Valores maiores de \(\lambda\) resultam em maior encolhimento dos coeficientes.REF?

Figura 34.7: Regressão ridge.

34.3.13 O que são modelos de regressão LASSO?

Regressão LASSO (Least Absolute Shrinkage and Selection Operator) utiliza penalização L1, que pode zerar coeficientes.REF?

Além de reduzir overfitting, também realiza seleção automática de variáveis.REF?

Enquanto a regressão ridge mantém todos os preditores, a LASSO pode excluir variáveis irrelevantes.REF?

34.4 Preparação de variáveis

34.4.1 Como preparar as variáveis categóricas para análise de regressão?

Variáveis fictícias (dummy) compreendem variáveis criadas para introduzir, nos modelos de regressão, informações contidas em outras variáveis que não podem ser medidas em escala numérica.311

Variáveis categóricas nominais, com 2 ou mais níveis, devem ser subdivididas em variáveis fictícias dicotômicas para ser usada em modelos de regressão.312

Cada nível da variável categórica nominal será convertido em uma nova variável fictícias dicotômica, tal que a nova variável dicotômica assume valor 1 para a presença do nível correspondente e 0 em qualquer outro caso.312

O pacote fastDummies313 fornece a função dummy_cols para preparar as variáveis categóricas fictícias para análise de regressão.

34.4.2 Por que é comum escolher a categoria mais frequente como referência em modelos epidemiológicos?

Maior estabilidade estatística: a categoria mais frequente costuma gerar estimativas mais estáveis, com menor erro padrão nos coeficientes das demais categorias.REF?

A escolha da referência não altera o ajuste nem o valor predito pelo modelo — apenas muda o ponto de comparação.REF?

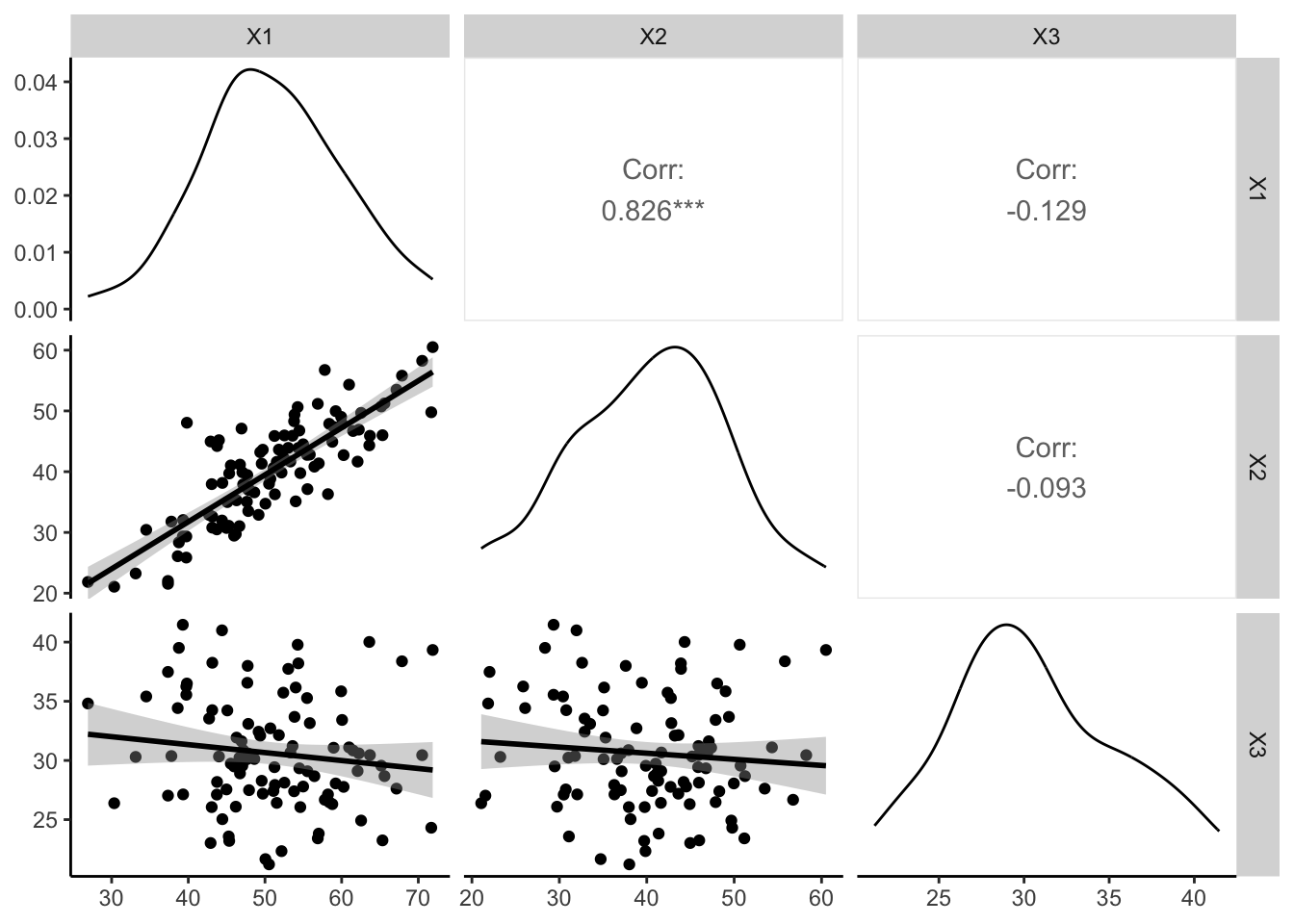

34.5 Multicolinearidade

34.5.1 O que é multicolinearidade?

- Multicolinearidade representa a intercorrelação entre as variáveis independentes (explanatórias) de um modelo.306

34.5.2 Como diagnosticar multicolinearidade de forma quantitativa?

Verifique a existência de multicolinearidade entre as variáveis candidatas.314

O Coeficiente de determinação (\(R^2\)) é uma medida de quão bem as variáveis independentes explicam a variabilidade da variável dependente. Valores próximos a 1 indicam que as variáveis independentes estão fortemente correlacionadas entre si, o que pode indicar multicolinearidade.306

O Fator de Inflação da Variância (variance inflation factor, VIF) é uma medida que quantifica o quanto a variância de um coeficiente de regressão é inflacionada devido à multicolinearidade. Valores de VIF maiores que 10 são frequentemente considerados indicativos de multicolinearidade significativa.306

O recíproco da VIF é chamado de Tolerância, que mede a proporção da variância de uma variável independente que não é explicada pelas outras variáveis independentes. Valores baixos de Tolerância (geralmente abaixo de 0.1) indicam multicolinearidade.306

O número de condições (Condition Number) é uma medida que avalia a estabilidade numérica de um modelo de regressão. Valores altos (entre 10 de 30) indicam multicolinearidade, e valores maiores que 30 indicam forte multicolinearidade.306

Figura 34.8: Multicolinearidade entre variáveis candidatas em modelos de regressão multivariável.

O pacote GGally307 fornece a função ggpairs para criar uma matriz gráfica de correlações bivariadas.

34.5.3 O que fazer em caso de multicolinearidade elevada?

Verifique a transformação (codificação) de variáveis numéricas em categóricas.306

Aumente o tamanho da amostra, se possível, para reduzir a multicolinearidade.306

Combine níveis de variáveis categóricas com baixa frequência de ocorrência.306

Combine variáveis numéricas altamente correlacionadas em uma única variável composta, como a média ou soma das variáveis.306

Considere a exclusão de variáveis altamente correlacionadas do modelo, especialmente se elas não forem essenciais para a análise.306

Use técnicas de seleção de variáveis, como seleção passo a passo, para identificar e remover variáveis redundantes.306

Use técnicas de regularização, como regressão ridge ou LASSO, que podem lidar com multicolinearidade ao penalizar coeficientes de regressão.306

34.6 Redução de dimensionalidade

34.6.1 Correlação bivariada pode ser usada para seleção de variáveis em modelos de regressão multivariável?

Seleção bivariada de variáveis — isto é, aplicação de testes de correlação em pares de variáveis candidatas e variável de desfecho afim de selecionar quais serão incluídas no modelo multivariável — é um dos erros mais comuns na literatura.292,314,316

A seleção bivariada de variáveis torna o modelo mais suscetível a otimismo no ajuste se as variáveis de confundimento não são adequadamente controladas.314,316

34.6.2 Variáveis sem significância estatística devem ser excluídas do modelo final?

Eliminar uma variável de um modelo significa anular o seu coeficiente de regressão (\(\beta = 0\)), mesmo que o valor estimado pelos dados seja outro. Desta forma, os resultados se afastam de uma solução de máxima verossimilhança (que tem fundamento teórico) e o modelo resultante é intencionalmente subótimo.292

Os coeficientes de regressão geralmente dependem do conjunto de variáveis do modelo e, portanto, podem mudam de valor (“mudança na estimativa” positiva ou negativa) se uma (ou mais) variável(is) for(em) eliminada(s) do modelo.292

34.6.3 Por que métodos de regressão gradual não são recomendados para seleção de variáveis em modelos de regressão multivariável?

Métodos diferentes de regressão gradual podem produzir diferentes seleções de variáveis de um mesmo banco de dados.312

Nenhum método de regressão gradual garante a seleção ótima de variáveis de um banco de dados.312

As regras de término da regressão baseadas em P-valor tendem a ser arbitrárias.312

34.6.4 O que pode ser feito para reduzir o número de variáveis candidatas em modelos de regressão multivariável?

Em caso de uma proporção baixa entre o número de participantes e de variáveis, use o conhecimento prévio da literatura para selecionar um pequeno conjunto de variáveis candidatas.314

Colapse categorias com contagem nula (células com valor igual a 0) de variáveis candidatas.314

Use simulações de dados para identificar qual(is) variável(is) está(ão) causando problemas de convergência do ajuste do modelo.314

A eliminação retroativa tem sido recomendada como a abordagem de regressão gradual mais confiável entre aquelas que podem ser facilmente alcançadas com programas de computador.292

34.6.5 Quando devemos forçar uma variável no modelo?

- Sempre que houver base teórica ou evidência prévia forte, ou se for a variável de exposição principal.255

34.7 Seleção de variáveis em regressão

34.7.1 O que é seleção de variáveis em regressão?

- Seleção de variáveis em regressão consiste em identificar, dentre um conjunto de preditores disponíveis, quais devem ser incluídos no modelo para otimizar o equilíbrio entre ajuste e parcimônia.317

34.7.2 Quais são os principais critérios de informação usados na seleção de variáveis?

Critérios de informação avaliam o ajuste do modelo penalizando a complexidade (número de preditores), ajudando a evitar overfitting.317

\(R^2_{adj}\) (34.7) penaliza o \(R^2\) pelo número de preditores, reduzindo o viés em modelos com muitas variáveis, onde \(n\) é o tamanho amostral, \(k\) o número de preditores, \(RSS\) a soma dos quadrados dos resíduos e \(SST\) a soma total dos quadrados.

\[\begin{equation} \tag{34.7} R^2_{adj} = 1 - \frac{(n-1)}{(n - k - 1)} \cdot \frac{RSS}{SST} \end{equation}\]

- \(AIC\) (Akaike Information Criterion) (34.8) mede o equilíbrio entre ajuste e complexidade:

\[\begin{equation} \tag{34.8} AIC = n \cdot \log\left(\frac{RSS}{n}\right) + 2k + n + n \cdot \log(2\pi) \end{equation}\]

- \(AICc\) (34.9) é uma versão corrigida do AIC, preferida para amostras pequenas:

\[\begin{equation} \tag{34.9} AIC_c = AIC + \frac{2(k+2)(k+3)}{n - (k + 2) - 1} \end{equation}\]

- \(C_p\) de Mallows compara o erro do modelo reduzido com o modelo completo, idealmente satisfazendo \(C_p \approx p\), onde \(m\) é o número total de preditores disponíveis, \(p\) o número de parâmetros (incluindo o intercepto), e \(RSS_{FULL}\) o erro quadrático residual do modelo completo:

\[\begin{equation} \tag{34.10} C_p = (n - m - 1)\frac{RSS}{RSS_{FULL}} - (n - 2p) \end{equation}\]

- \(BIC\) (Bayesian Information Criterion) (34.11) penaliza fortemente modelos complexos:

\[\begin{equation} \tag{34.11} BIC = n \cdot \log\left(\frac{RSS}{n}\right) + k \cdot \log(n) + n + n \cdot \log(2\pi) \end{equation}\]

34.7.3 Quais algoritmos podem ser usados para seleção automática?

Seleção progressiva (forward selection): começa com o modelo nulo e adiciona, a cada iteração, a variável que mais melhora o critério escolhido. O processo para quando nenhuma nova variável melhora o modelo.317

Eliminação retrógrada (backward elimination): parte do modelo completo e remove, a cada iteração, a variável cuja exclusão mais melhora o critério. O processo para quando nenhuma remoção melhora o ajuste.317

Leaps-and-bounds: método exato que examina apenas uma fração dos \(2^m\) modelos possíveis, determinando os melhores subconjuntos para cada tamanho de preditor (usando os critérios AIC, BIC, AICc, R² ajustado e Cp).317

Esses métodos podem divergir em presença de alta multicolinearidade ou amostras pequenas, e devem ser acompanhados de diagnóstico de resíduos e validação cruzada.317

O pacote leaps318 fornece a função regsubsets para realizar os métodos de seleção de variáveis.

O pacote olsrr319 fornece a função ols_step_all_possible para testar todos os subconjuntos de potenciais preditores de uma regressão.

O pacote olsrr319 fornece a função ols_step_best_subset para selecionar o melhor de todos os subconjuntos de potenciais preditores de uma regressão, de acordo com critérios objetivos.

Ferreira, Arthur de Sá. Ciência com R: Perguntas e respostas para pesquisadores e analistas de dados. Rio de Janeiro: 1a edição,