Capítulo 17 Distribuições e parâmetros

17.1 Distribuições de probabilidade

17.1.1 O que são distribuições de probabilidade?

- Uma distribuição de probabilidade é uma função que descreve os valores possíveis ou o intervalo de valores de uma variável (eixo horizontal) e a frequência com que cada valor é observado (eixo vertical).111

17.1.2 Como representar distribuições de probabilidade?

Tabelas de frequência, polígonos de frequência, gráficos de barras, histogramas e boxplots são formas de representar distribuições de probabilidade.172

Tabelas de frequência mostram as categorias de medição e o número de observações em cada uma. É necessário conhecer o intervalo de valores (mínimo e máximo), que é dividido em intervalos arbitrários chamados “intervalos de classe”.172

Se houver muitos intervalos, não haverá redução significativa na quantidade de dados, e pequenas variações serão perceptíveis. Se houver poucos intervalos, a forma da distribuição não poderá ser adequadamente determinada.172

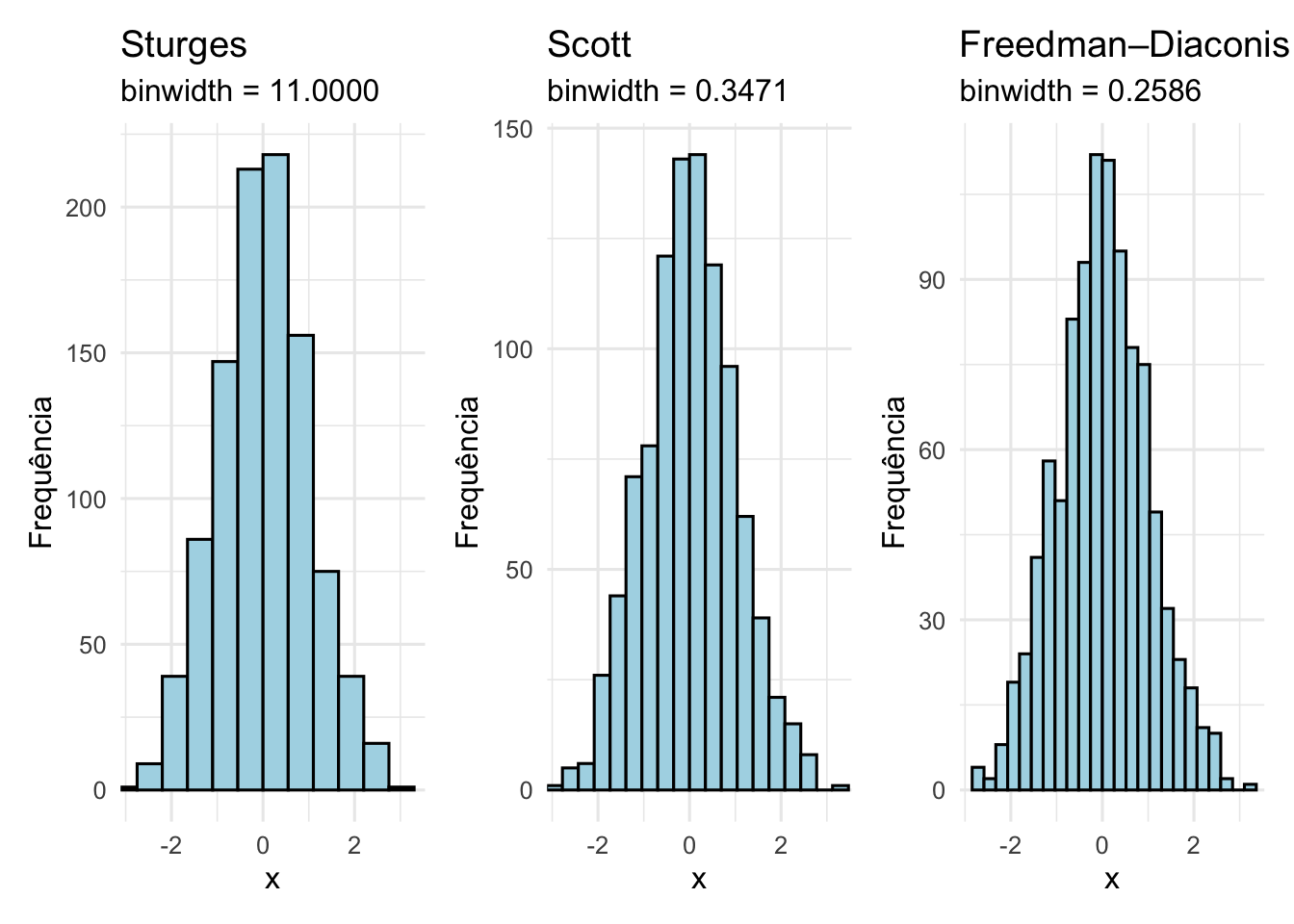

A quantidade de intervalos pode ser determinada pelo método de Sturges, que é dado pela fórmula \(k = 1 + 3.322 \times \log_{10}(n)\), onde \(k\) é o número de intervalos e \(n\) é o número de observações.173

A quantidade de intervalos pode ser determinada pelo método de Scott, que é dado pela fórmula \(h = 3.5 \times \text{sd}(x) \times n^{-1/3}\), onde \(h\) é a largura do intervalo, \(\text{sd}(x)\) é o desvio-padrão e \(n\) é o número de observações.174

A quantidade de intervalos pode ser determinada pelo método de Freedman-Diaconis, que é dado pela fórmula \(h = 2 \times \text{IQR}(x) \times n^{-1/3}\), onde \(h\) é a largura do intervalo, \(\text{IQR}(x)\) é o intervalo interquartil e \(n\) é o número de observações.175

Figura 17.1: Histogramas com diferentes métodos de binning.: Sturges, Scott e Freedman-Diaconis.

A largura das classes pode ser determinada dividindo o intervalo total de observações pelo número de classes. Recomenda-se larguras iguais, mas larguras desiguais podem ser usadas quando existirem grandes lacunas nos dados ou em contextos específicos. Os intervalos devem ser mutuamente exclusivos e não sobrepostos, evitando intervalos abertos (ex.: <5, >10).172

Polígonos de frequência são gráficos de linhas que conectam os pontos médios de cada barra do histograma. Eles são úteis para comparar duas ou mais distribuições de frequência.172

Gráficos de barra verticais ou horizontais representam a distribuição de frequências de uma variável categórica. A altura de cada barra é proporcional à frequência da classe. A largura da barra é igual à largura da classe. A área de cada barra é proporcional à frequência da classe. A área total do gráfico de barras é igual ao número total de observações.172

Histogramas representam a distribuição de frequências de uma variável contínua. A altura de cada barra é proporcional à frequência da classe. A largura da barra é igual à largura da classe. A área de cada barra é proporcional à frequência da classe. A área total do histograma é igual ao número total de observações.172

Boxplots representam a distribuição de frequências de uma variável contínua. A linha central divide os dados em duas partes iguais (mediana ou Q2). A caixa inferior representa o primeiro quartil (Q1) e a caixa superior representa o terceiro quartil (Q3). A linha inferior é o mínimo e a linha superior é o máximo. Os valores atípicos são representados por pontos individuais.172

O pacote grDevices176 fornece a função nclass para determinar a quantidade de classes de um histograma com os métodos de Sturge173, Scott174 ou Freedman-Diaconis175.

O pacote ggplot2177 fornece a função geom_freqpoly para criar histogramas.

17.1.3 Quais características definem uma distribuição?

- Uma distribuição pode ser definida por modelos matemáticos e caracterizada por parâmetros de tendência central, dispersão, simetria e curtose.REF?

17.1.4 Quais são as distribuições mais comuns?

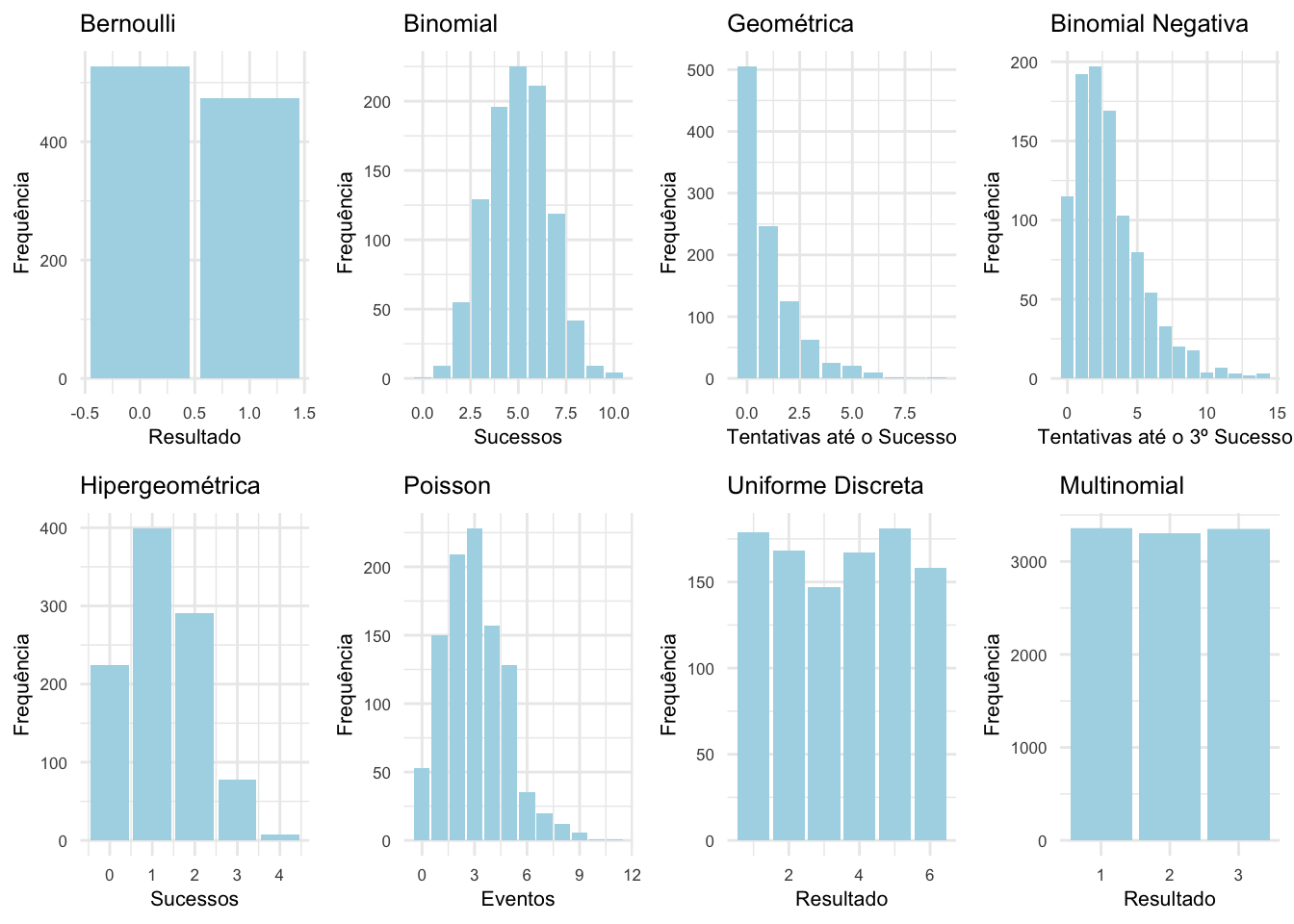

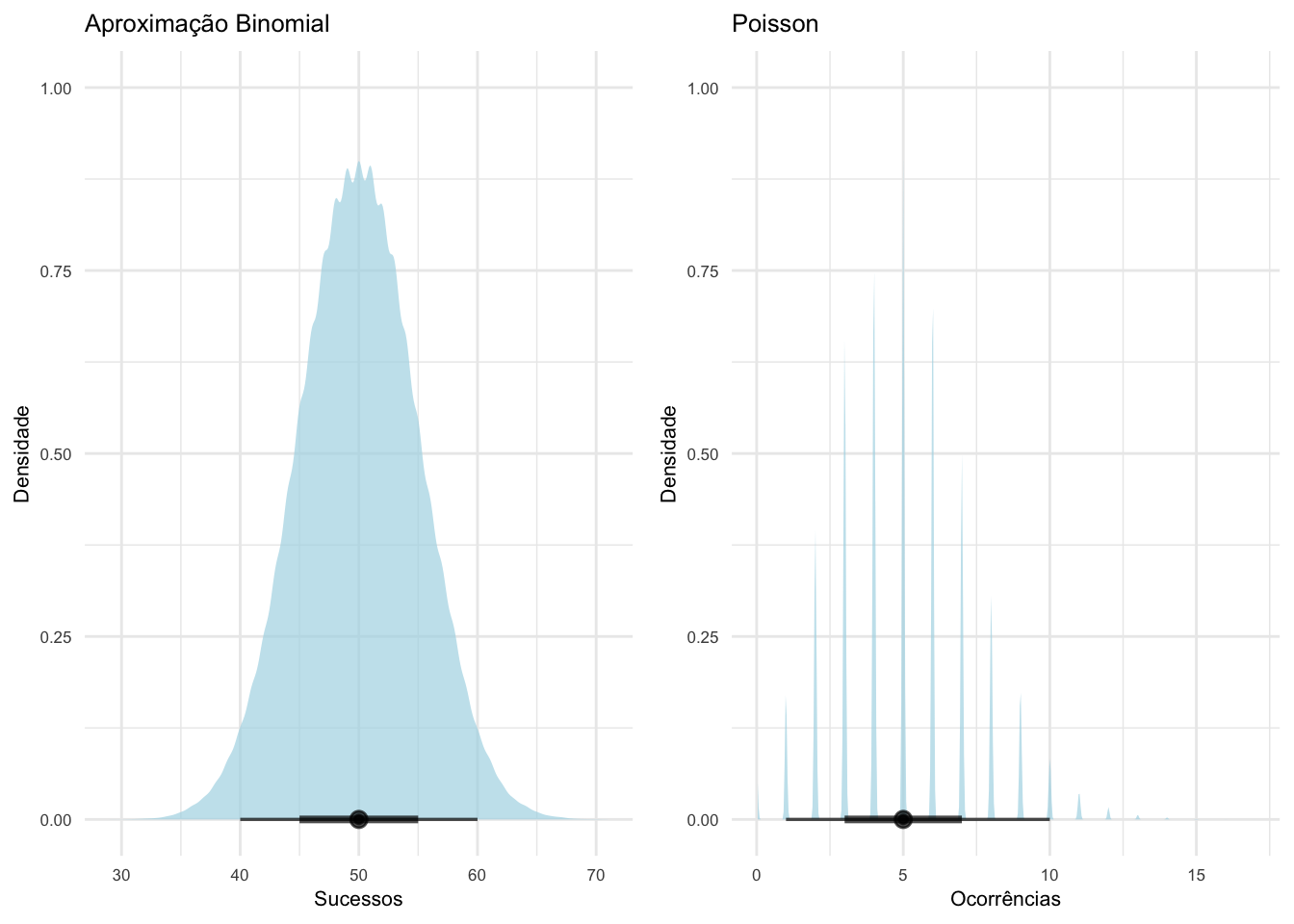

Distribuções discretas:

Bernoulli: resultado de um único teste com dois possíveis desfechos (sucesso ou fracasso).REF?

Binomial: número de sucessos em k tentativas.REF?

Geométrica: número de testes até o 1o sucesso.REF?

Binomial negativa: número de testes até o k-ésimo sucesso.REF?

Hipergeométrica: número de indivíduos na amostra tomados sem reposição.REF?

Poisson: número de eventos em um intervalo de tempo fixo.REF?

Uniforme: resultados (finitos) que são igualmente prováveis.REF?

Multinomial: resultados de múltiplos testes com mais de dois possíveis desfechos.REF?

Figura 17.2: Distribuições discretas e suas funções de probabilidade.

Distribuições contínuas:

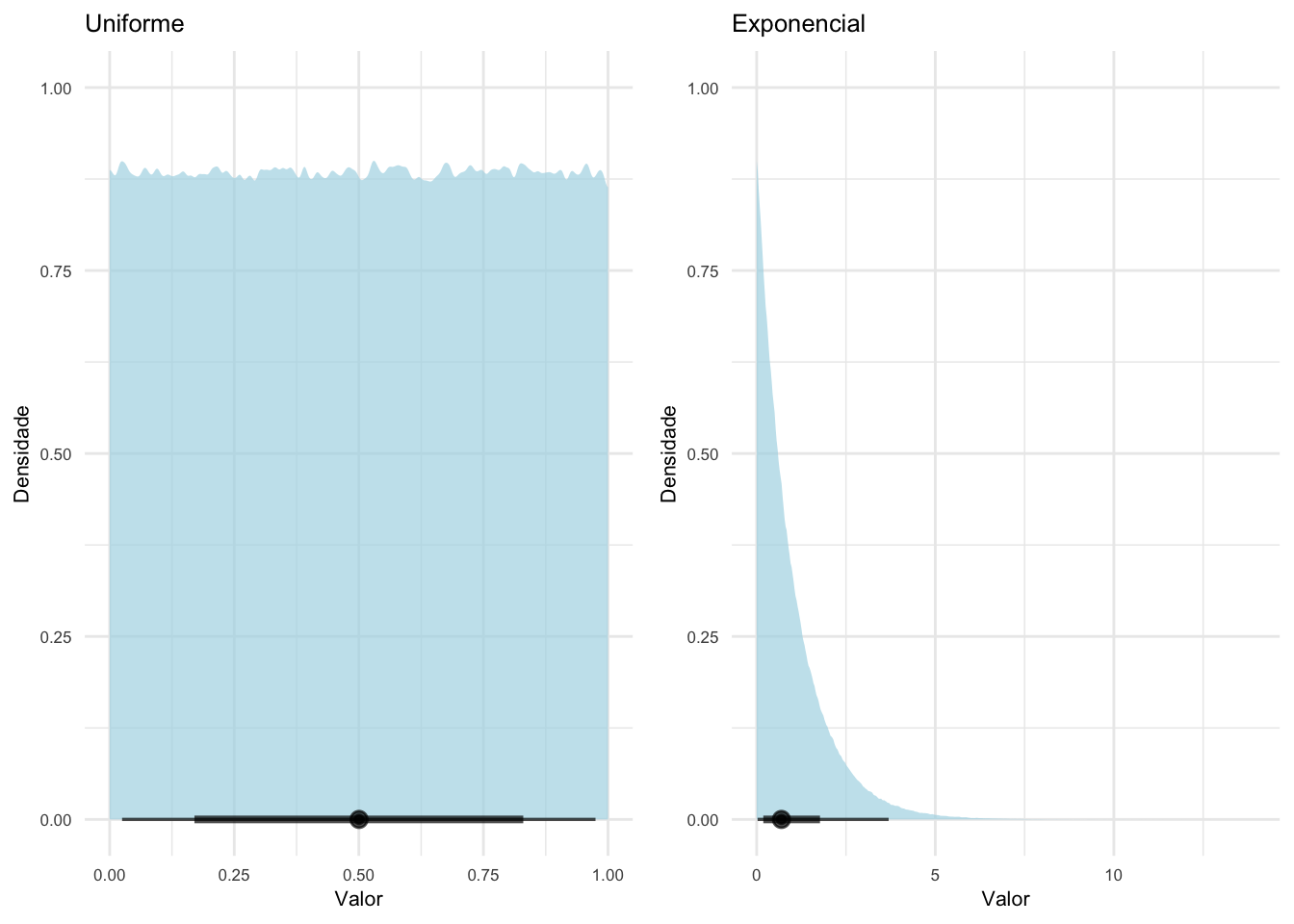

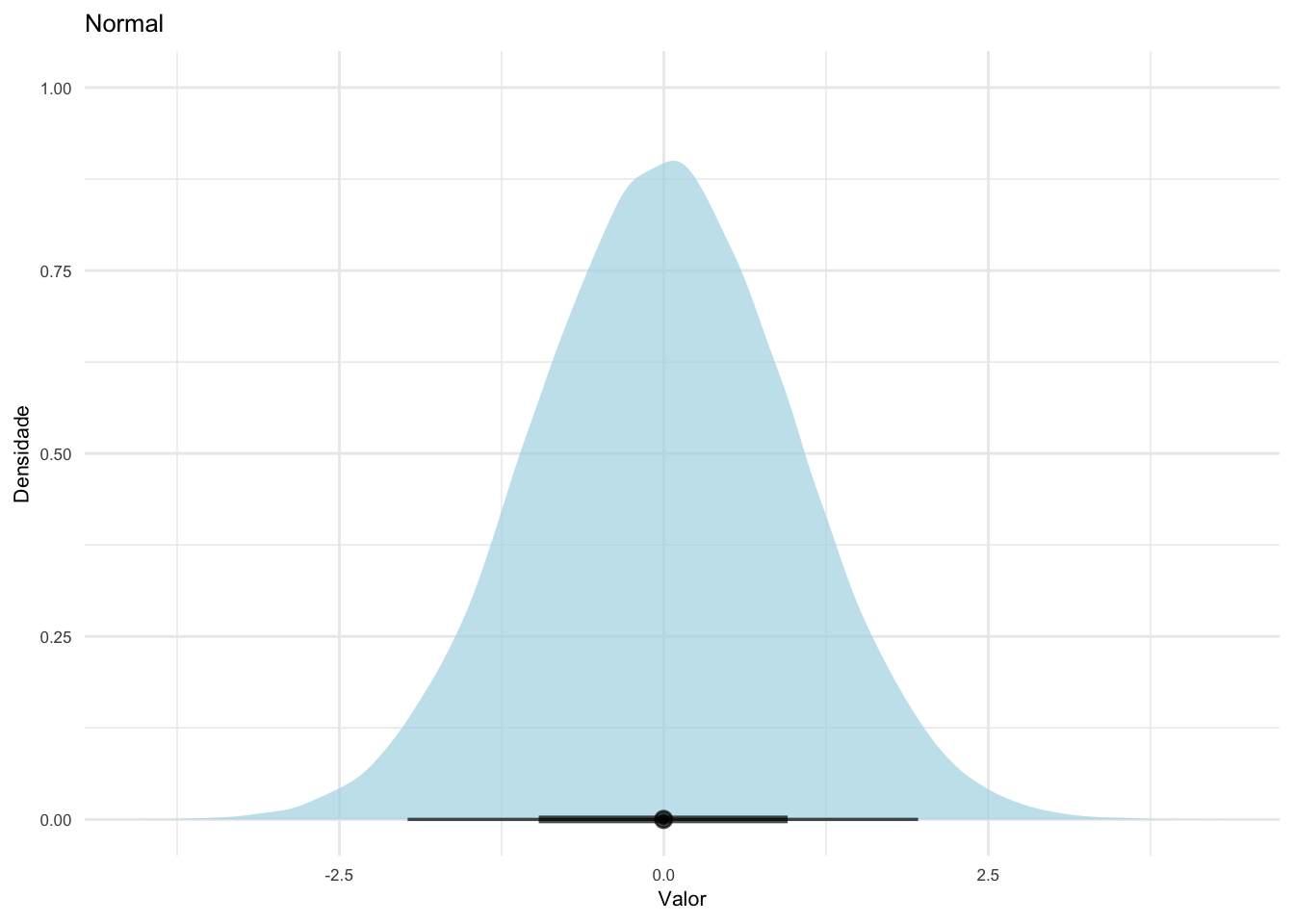

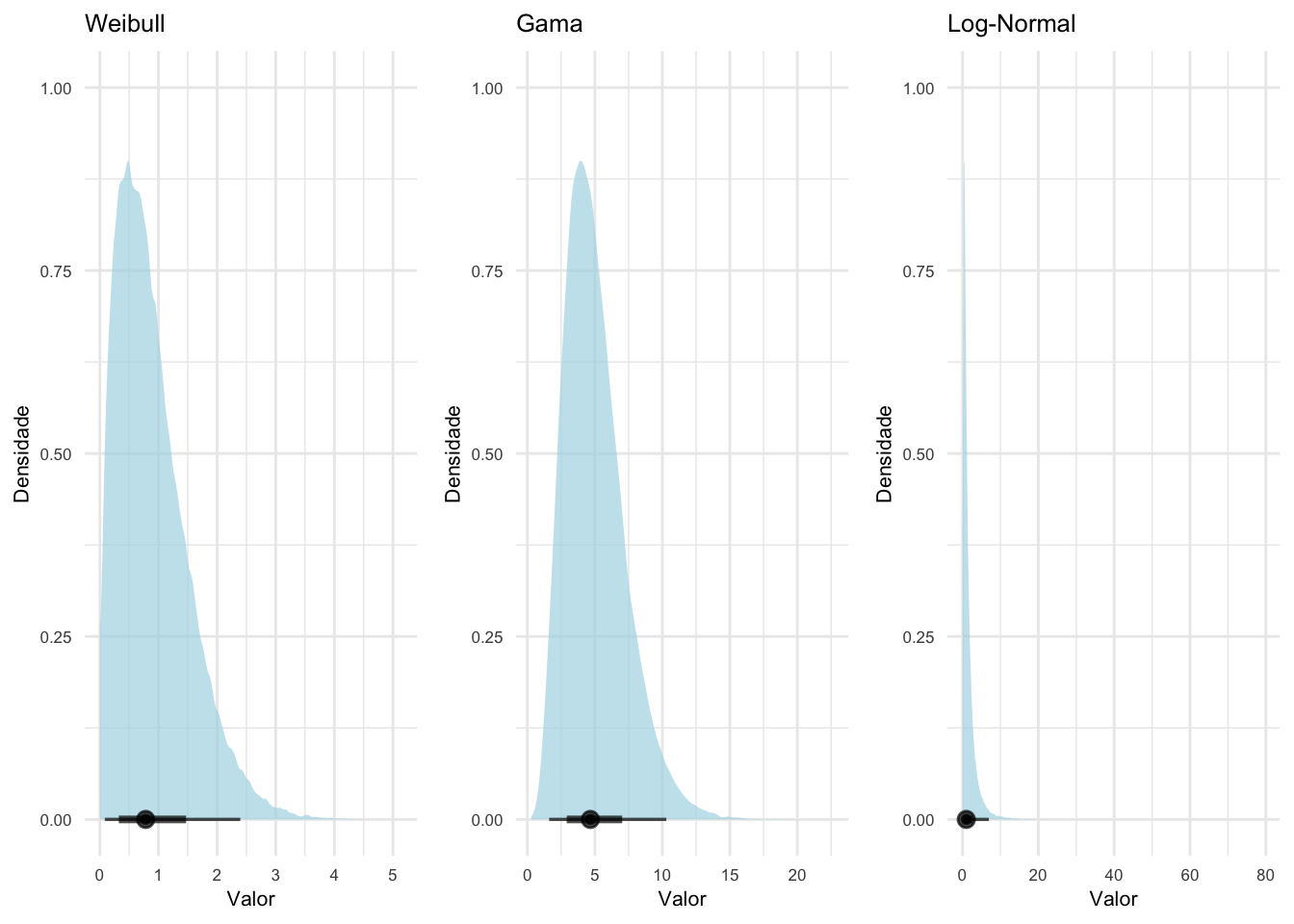

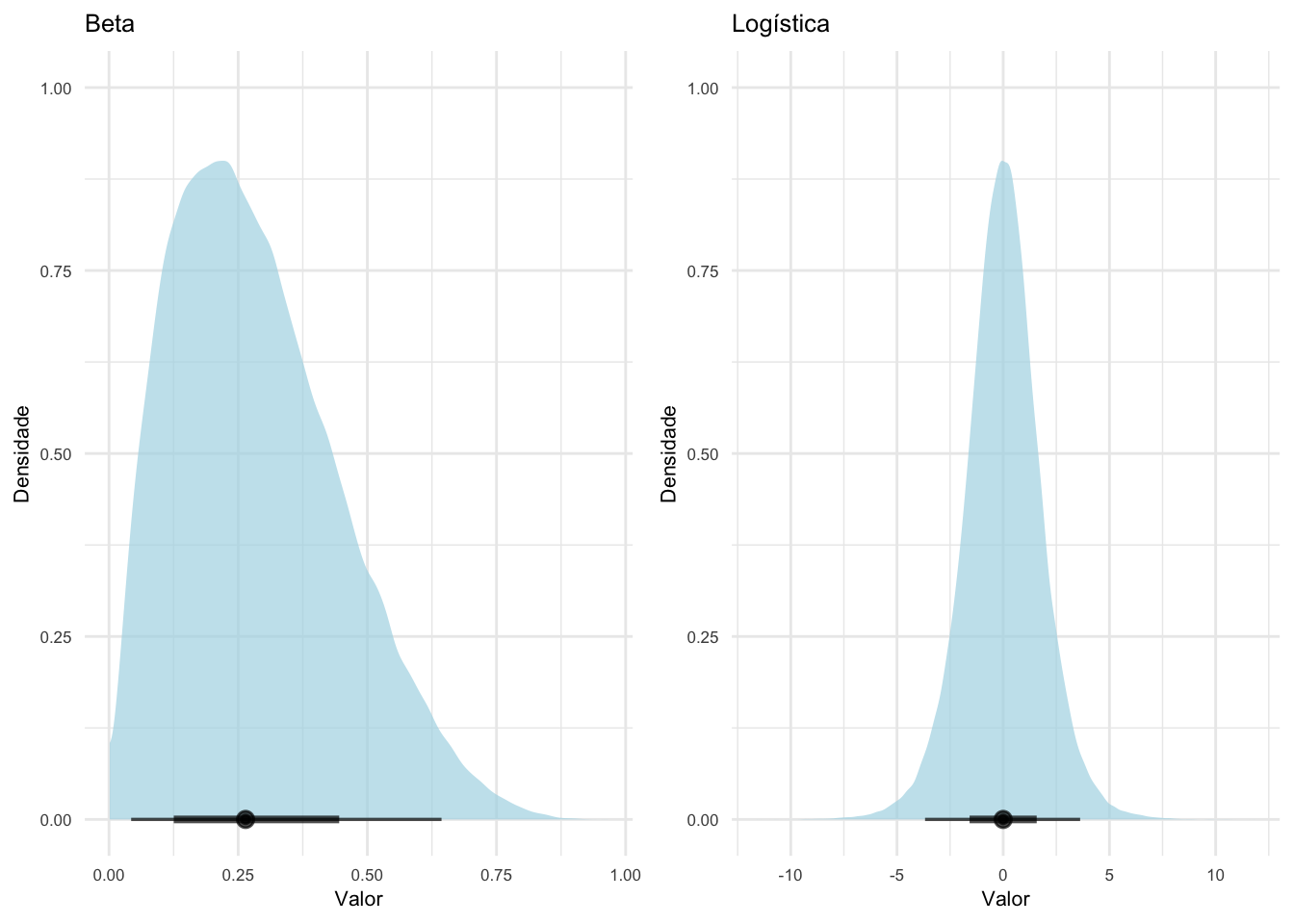

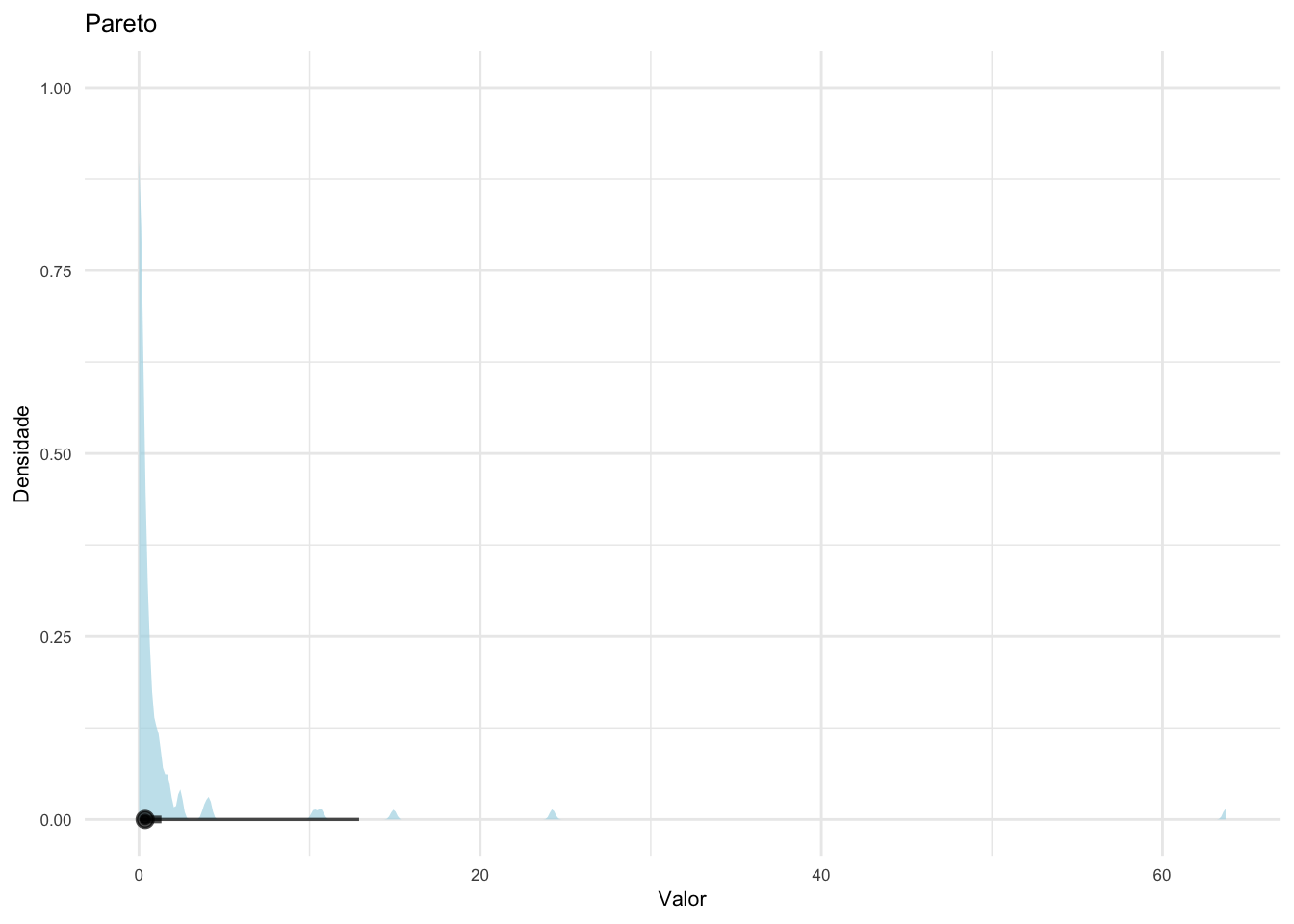

Figura 17.3: Distribuições contínuas básicas e suas funções de densidade.

Figura 17.4: Distribuições contínuas aproximadas e suas funções de densidade.

Figura 17.5: Distribuições contínuas aproximadas e suas funções de densidade.

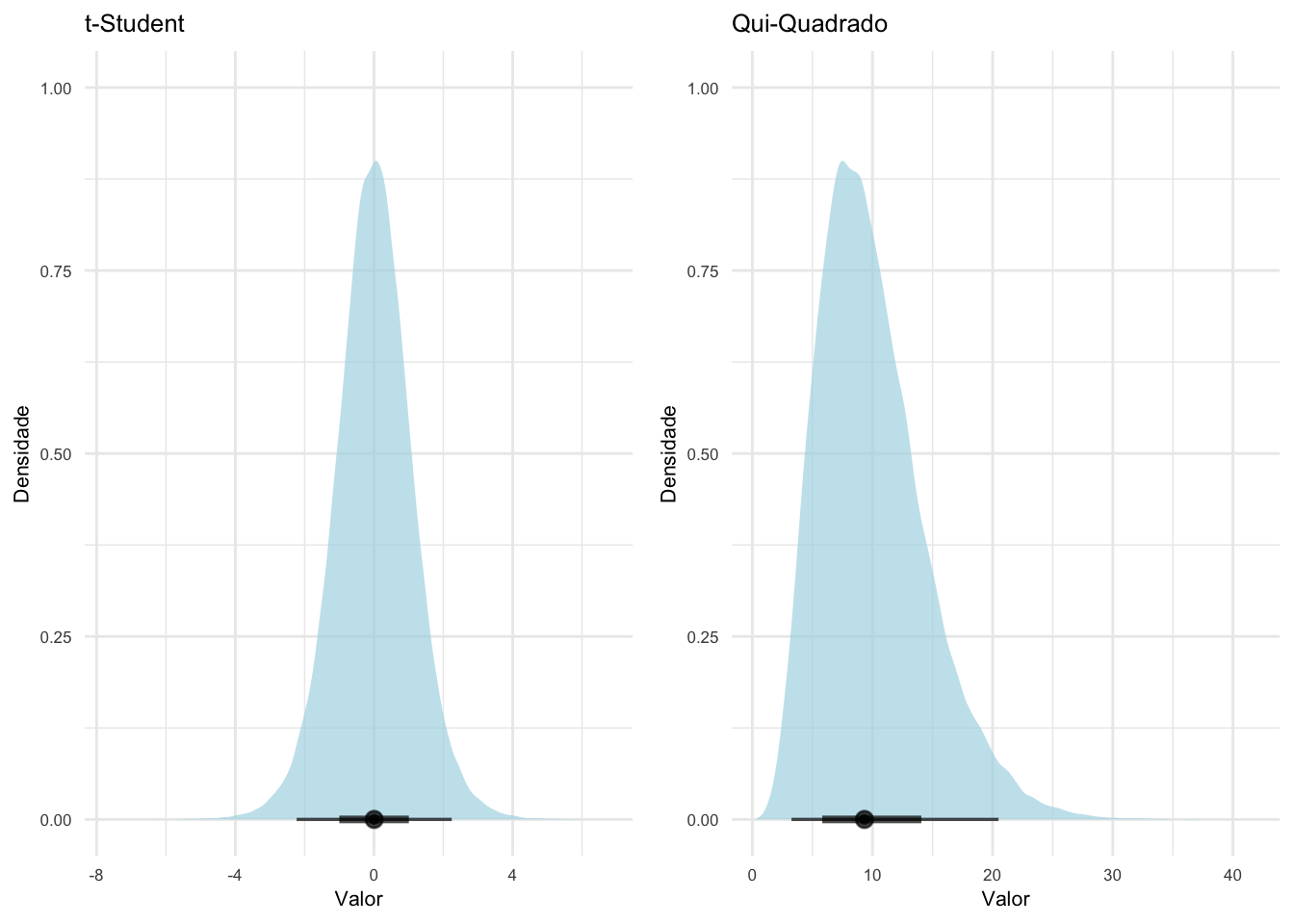

Figura 17.6: Distribuições contínuas para inferência e suas funções de densidade.

Figura 17.7: Distribuições contínuas para dados específicos e suas funções de densidade.

Figura 17.8: Distribuições contínuas para probabilidades e proporções e suas funções de densidade.

Figura 17.9: Distribuições contínuas com caudas pesadas e suas funções de densidade.

17.1.5 Quais são as funções de uma distribuição?

Função de massa de probabilidade (probability mass function, pmf).REF?

Função de distribuição cumulativa (cumulative distribution function, cdf).REF?

Função quantílicas (quantile function, qf).REF?

Função geradora de números aleatórios (random function, rf).REF?

O pacote stats134 fornece funções de distribuição de probabilidade (p), funções de densidade (d), funções quantílicas (q) e funções geradores de números aleatórios (r) para as distribuições normal, Student t, binomial, qui-quadrado, uniforme, dentre outras.

O pacote ggdist178 fornece a função geom_slabinterval para criar gráficos de distribuição de probabilidade (p) e funções de densidade (d) as distribuições.

O pacote ggfortify179 fornece a função ggdistribution para criar gráficos de distribuição de probabilidade (p), funções de densidade (d), funções quantílicas (q) e funções geradores de números aleatórios (r) para as distribuições.

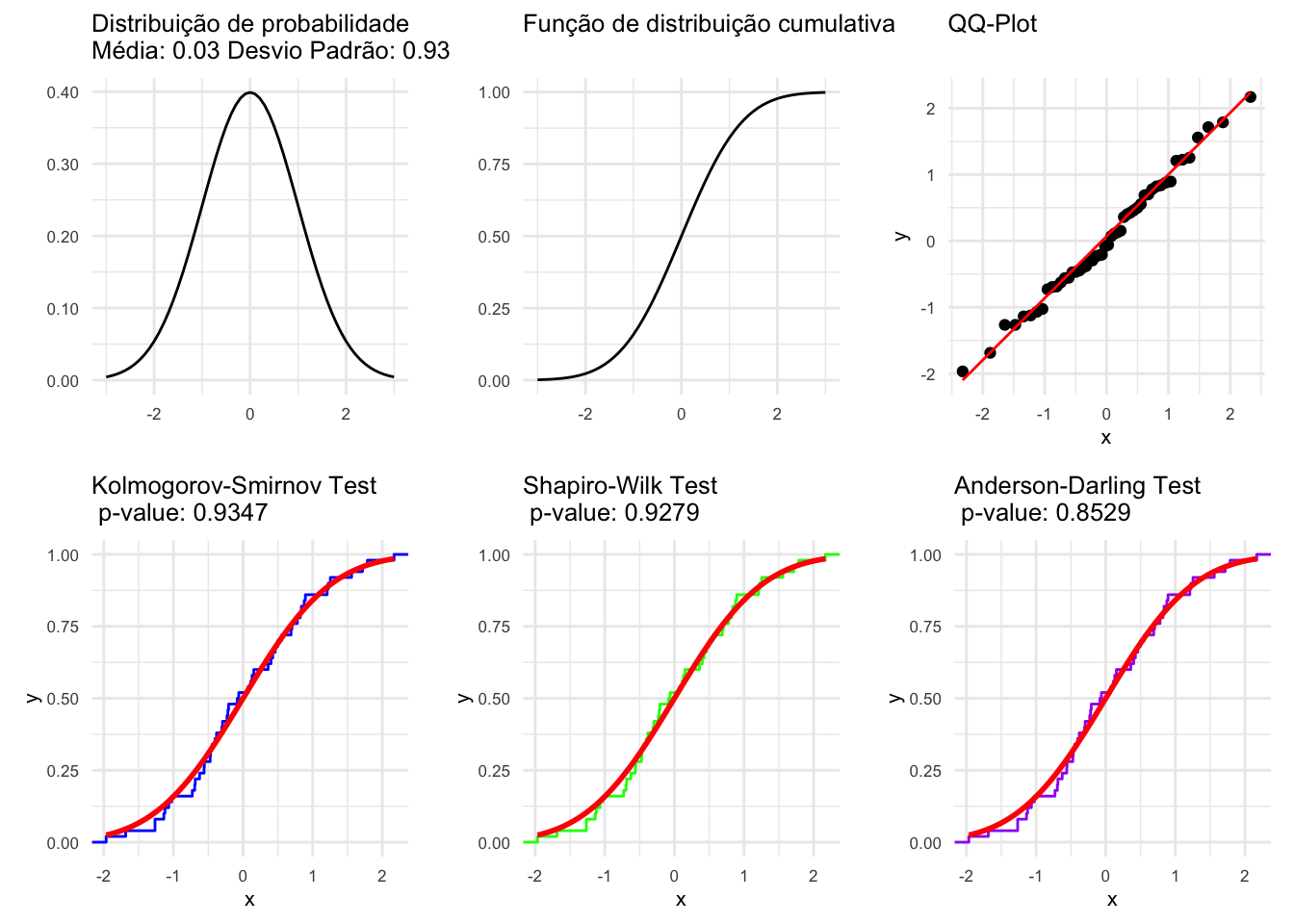

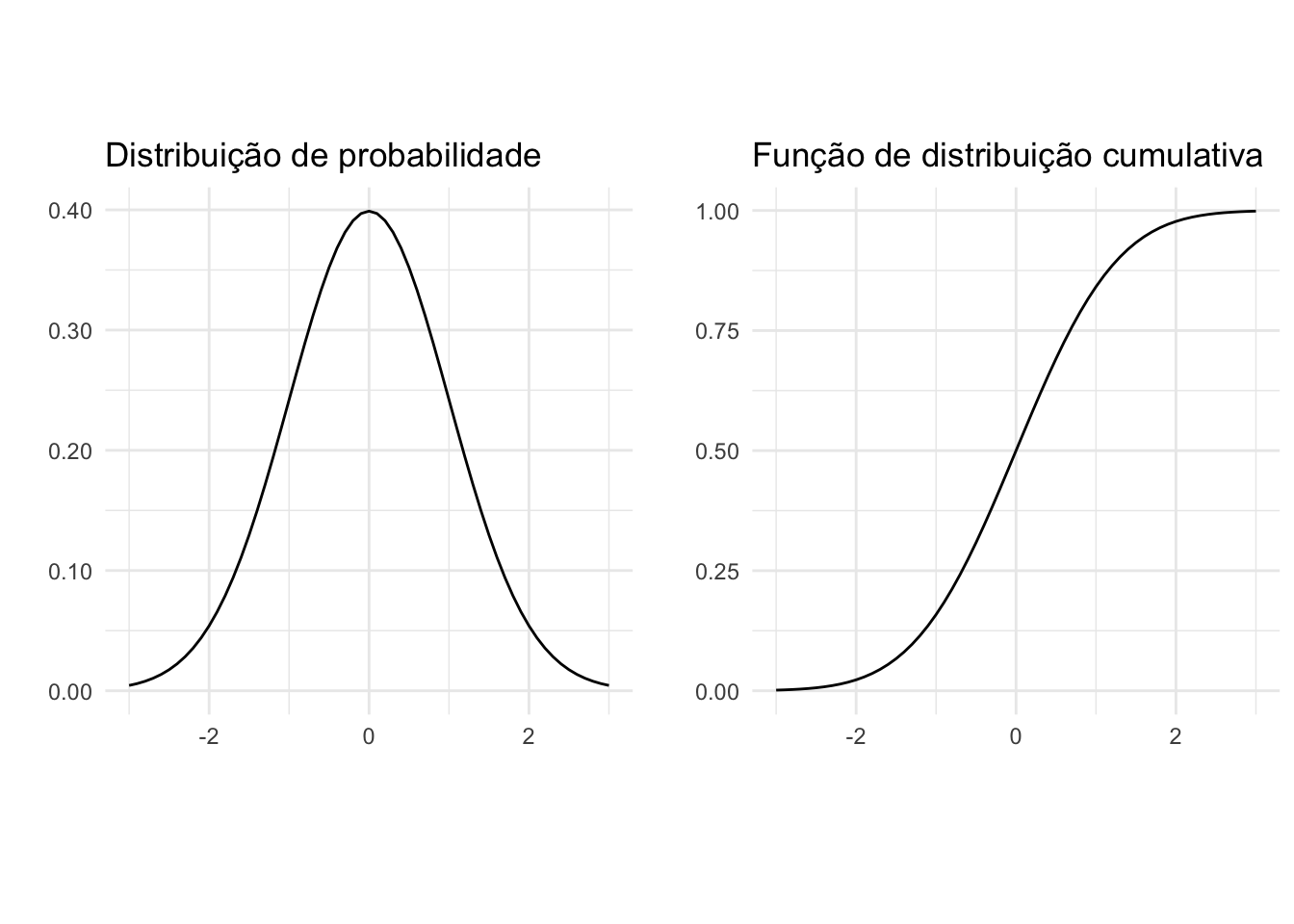

17.1.6 O que é a distribuição normal?

A distribuição normal (ou gaussiana) é uma distribuição com desvios simétricos positivos e negativos em torno de um valor central.112

Em uma distribuição normal, o intervalo de 1 desvio-padrão (±1DP) inclui cerca de 68% dos dados; de 2 desvios-padrão (±2DP) cerca de 95% dos dados; e no intervalo de 3 desvios-padrão (±3DP) cerca de 99% dos dados.112

Figura 17.10: Distribuições e funções de probabilidade.

17.2 Distribuições multivariadas

17.2.1 O que são distribuições multivariadas?

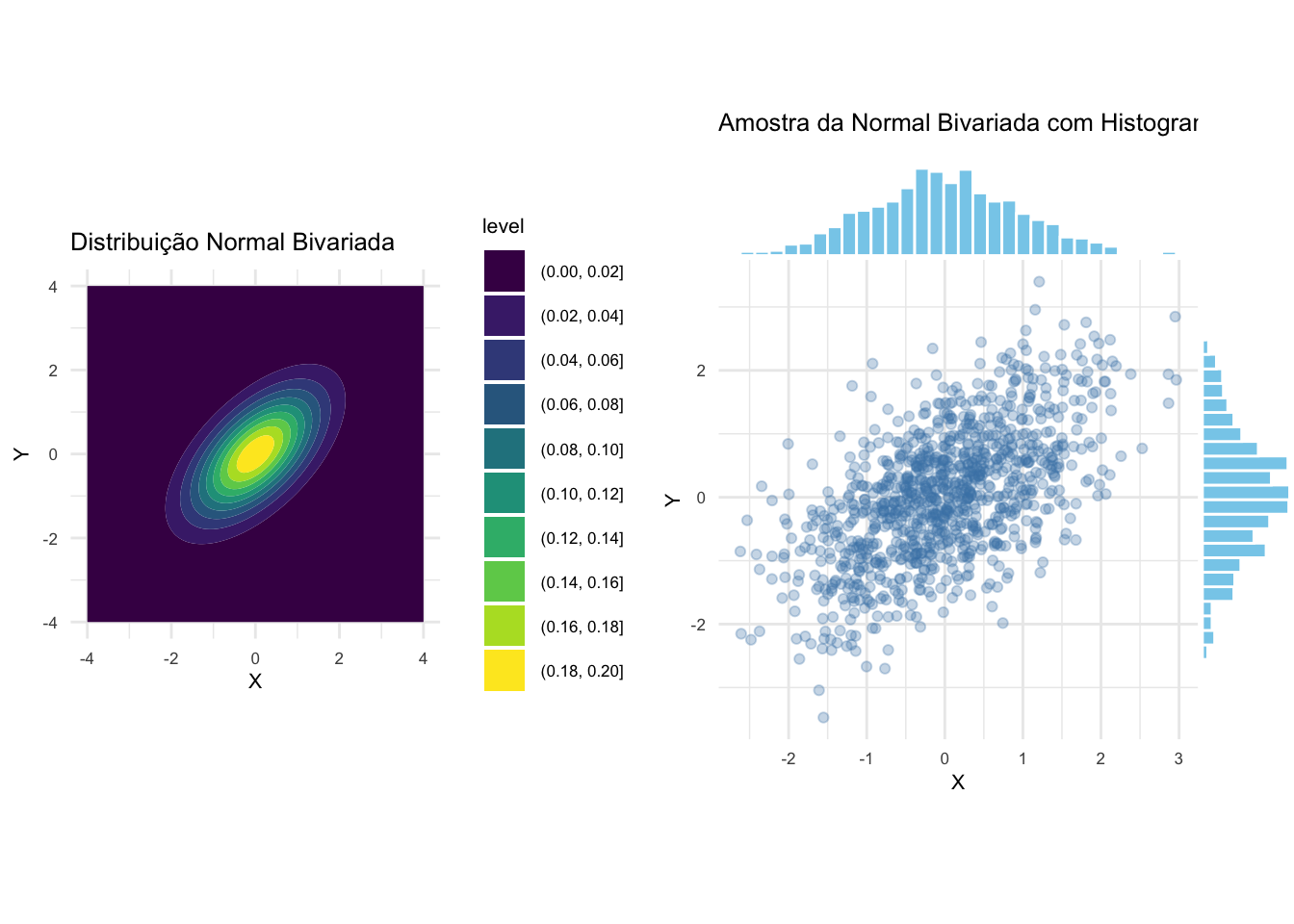

Distribuições multivariadas descrevem a probabilidade conjunta de duas ou mais variáveis aleatórias.REF?

Exemplos de distribuições multivariadas incluem a distribuição normal multivariada, a distribuição t multivariada, a distribuição binomial multinomial e a distribuição de Dirichlet.REF?

Figura 17.12: Distribuição normal bivariada e amostra simulada com histogramas marginais.

17.3 Parâmetros

17.3.1 O que são parâmetros?

Parâmetros são informações que definem um modelo teórico, como propriedades de uma coleção de indivíduos.110

Parâmetros definem características de uma população inteira, tipicamente não observados por ser inviável ter acesso a todos os indivíduos que constituem tal população.111

17.3.2 O que é uma análise paramétrica?

Testes paramétricos possuem suposições sobre as características e/ou parâmetros da distribuição dos dados na população.111

Testes paramétricos assumem que: a variável é quantitativa numérica (contínua); os dados foram amostrados de uma população com distribuição normal; a variância da(S) amostra(s) é igual à da população; as amostras foram selecionadas de modo aleatório na população; os valores de cada amostra são independentes entre si.111,112

Testes paramétricos são baseados na suposição de que os dados amostrais provêm de uma população com parâmetros fixos determinando sua distribuição de probabilidade.8

17.3.3 O que é uma análise não paramétrica?

Testes não-paramétricos fazem poucas suposições, ou menos rigorosas, sobre as características e/ou parâmetros da distribuição dos dados na população.111,112

Testes não-paramétricos são úteis quando as suposições de normalidade não podem ser sustentadas.112

17.3.4 Devemos testar as suposições de normalidade?

- Testes preliminares de normalidade não são necessários para a maioria dos testes paramétricos de comparação, pois eles são robustos contra desvios moderados da normalidade. Normalidade da distribuição deve ser estabelecida para a população.180

17.3.5 Por que as análises paramétricas são preferidas?

Em geral, testes paramétricos são mais robustos (isto é, possuem menores erros tipo I e II) que seus testes não-paramétricos correspondentes.111,181,182

Testes não-paramétricos apresentam menor poder estatístico (maior erro tipo II) comparados aos testes paramétricos correspondentes.112

17.4 Erro

17.4.1 Que parâmetros de erro podem ser estimados?

- Margem de erro (ME).(17.1).

\[\begin{equation} \tag{17.1} ME = z_{\alpha/2} \cdot \frac{\sigma}{\sqrt{n}} \end{equation}\]

\[\begin{equation} \tag{17.2} EPM = \frac{\sigma}{\sqrt{n}} \end{equation}\]

\[\begin{equation} \tag{17.3} \widehat{EPM} = \frac{s}{\sqrt{n}} \end{equation}\]

- Intervalo de confiança para variância conhecida (17.4) e desconhecida (17.5): Captura a média populacional correspondente ao nível de significância \(\alpha\) pré-estabelecido112,183,186,187.

\[\begin{equation} \tag{17.4} IC = \bar{x} \pm z_{\alpha/2} \cdot \frac{\sigma}{\sqrt{n}} \end{equation}\]

\[\begin{equation} \tag{17.5} IC = \bar{x} \pm t_{\alpha/2, n-1} \cdot \frac{s}{\sqrt{n}} \end{equation}\]

17.5 Tendência central

17.5.1 Que parâmetros de tendência central podem ser estimados?

\[\begin{equation} \tag{17.6} \bar{x} = \frac{\sum_{i=1}^{n} x_i}{n} \end{equation}\]

\[\begin{equation} \tag{17.7} \bar{x}_p = \frac{\sum_{i=1}^{n} w_i x_i}{\sum_{i=1}^{n} w_i} \end{equation}\]

\[\begin{equation} \tag{17.8} \bar{x}_g = \left( \prod_{i=1}^{n} x_i \right)^{\frac{1}{n}} \end{equation}\]

\[\begin{equation}

\tag{17.9}

\bar{x}_h = \frac{n}{\sum_{i=1}^{n} \frac{1}{x_i}}

\end{equation}\]

\[\begin{equation} \tag{17.10} \tilde{x} = \begin{cases} x_{\left(\frac{n+1}{2}\right)}, & \text{se } n \text{ é ímpar} \\ \frac{x_{\left(\frac{n}{2}\right)} + x_{\left(\frac{n}{2} + 1\right)}}{2}, & \text{se } n \text{ é par} \end{cases} \end{equation}\]

- Moda (17.11), onde \(f(x)\) é a função de frequência absoluta ou relativa e \(x_1, x_2, \ldots, x_n\) são os valores observados.112,183,189

\[\begin{equation} \tag{17.11} \operatorname{Mo} \in \arg\max_{x \in \{x_1,\ldots,x_n\}} f(x) \end{equation}\]

- Moda (dados agrupados) (17.12), onde: \(L\) = limite inferior da classe modal; \(f_1\) = frequência da classe modal; \(f_0\) = frequência da classe anterior à classe modal; \(f_2\) = frequência da classe posterior à classe modal; \(h\) = amplitude da classe modal.

\[\begin{equation} \tag{17.12} \operatorname{Mo} = L + \frac{(f_1 - f_0)}{(f_1 - f_0) + (f_1 - f_2)} \cdot h \end{equation}\]

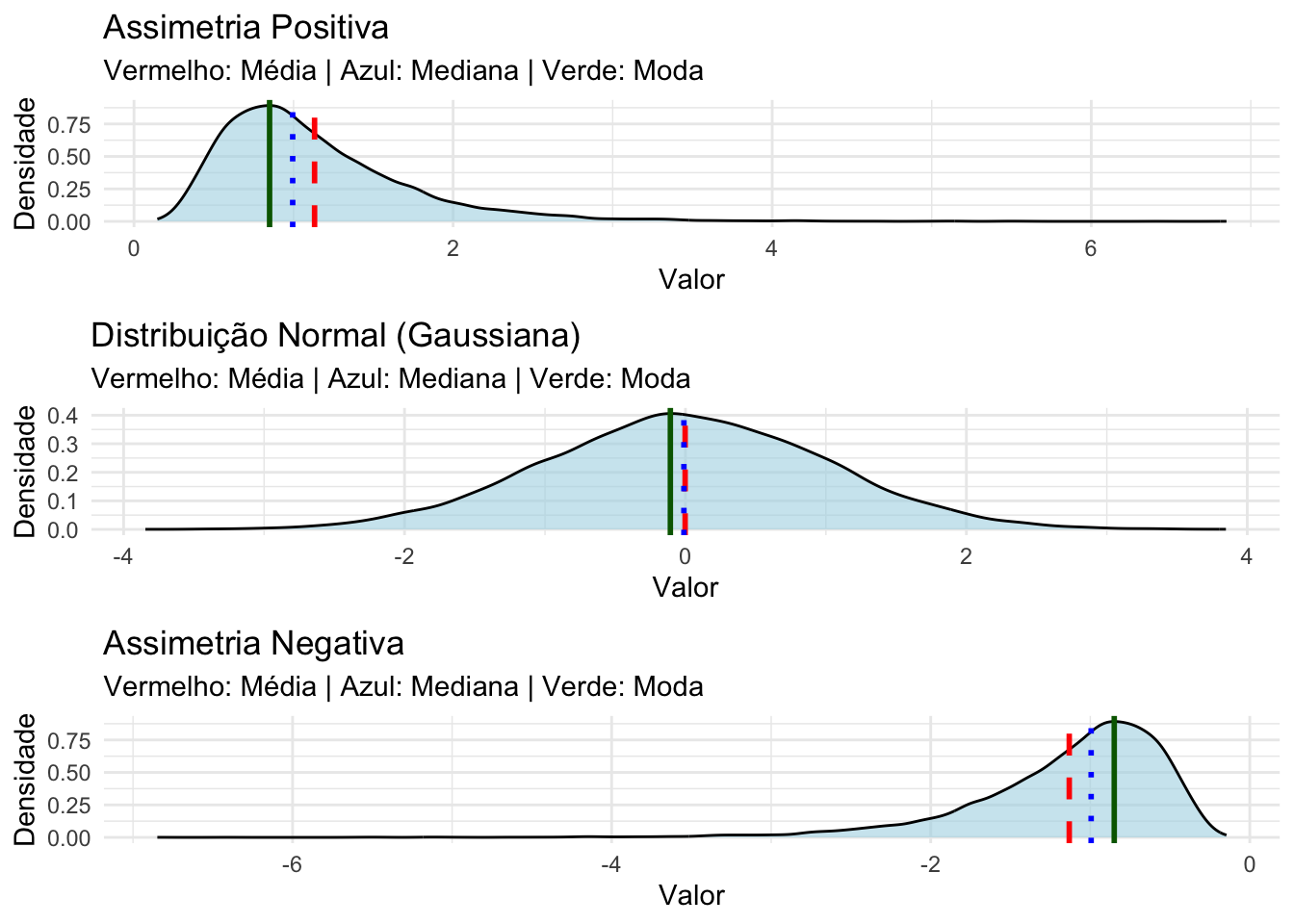

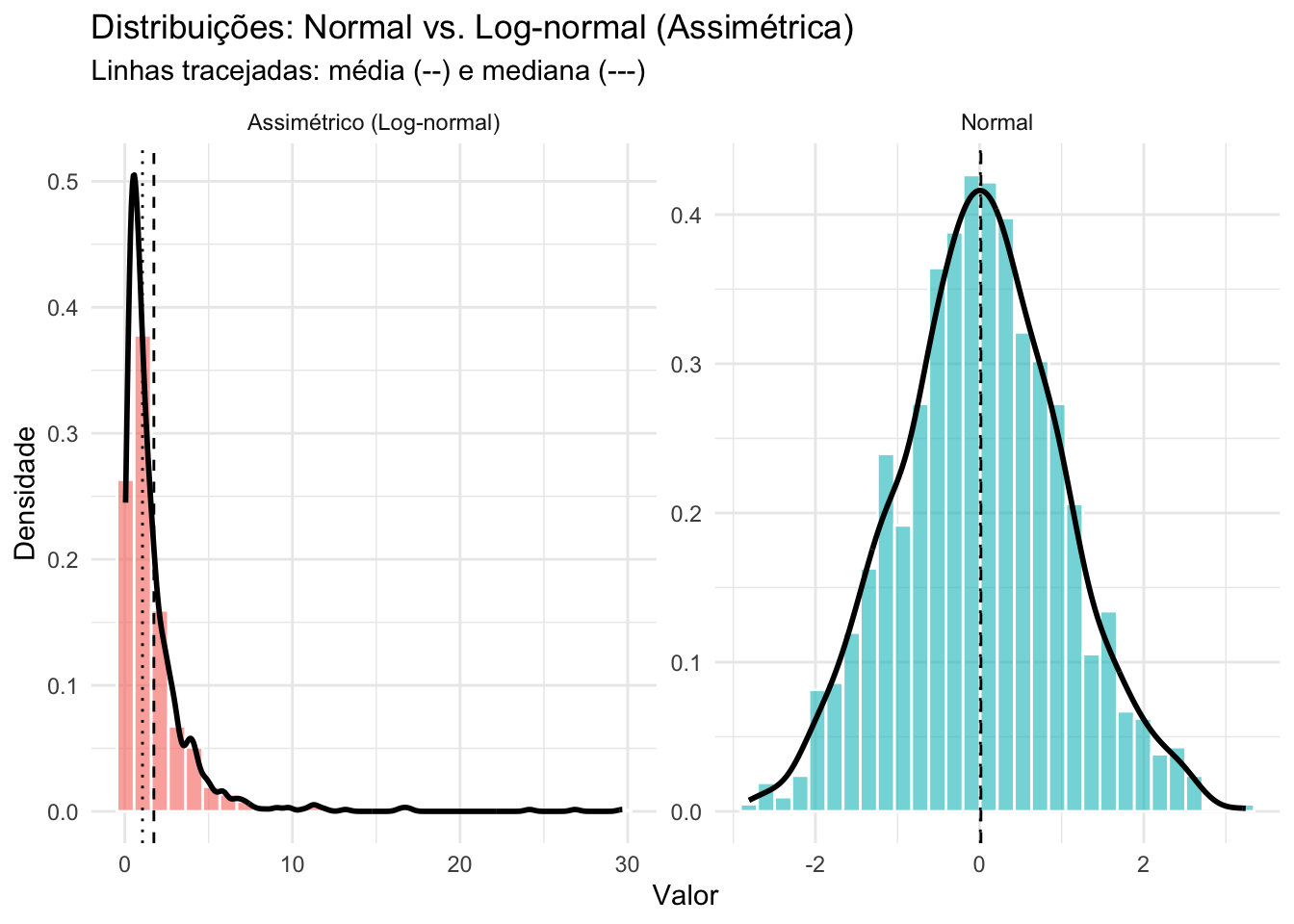

A posição relativa das medidas de tendência central (média, mediana e moda) depende da forma da distribuição.189

Em uma distribuição normal, as três medidas são idênticas.189

A média é sempre puxada para os valores extremos, por isso é deslocada para a cauda em distribuições assimétricas.189

A mediana fica entre a média e a moda em distribuições assimétricas.189

A moda é o valor mais frequente e, portanto, se localiza no pico da distribuição assimétrica.189

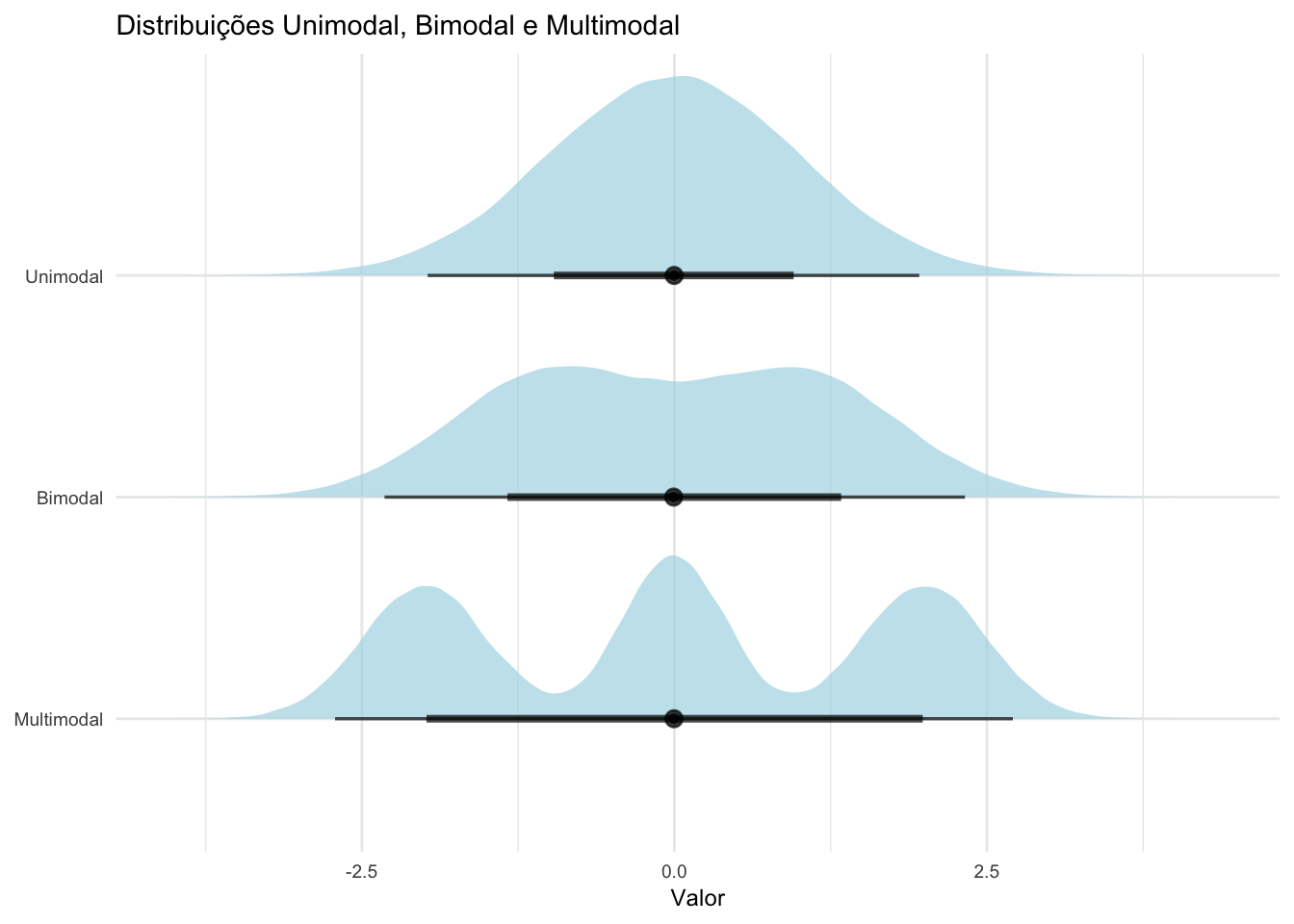

Uma distribuição pode uma moda (unimodal), duas modas (bimodal) ou três ou mais modas (multimodal), indicando a presença de mais de um valor com alta frequência.189

Figura 17.13: Distribuições unimodal, bimodal e multimodal.

Figura 17.14: Parâmetros de tendência central em distribuições assimétricas e normais.

17.5.2 Como escolher o parâmetro de tendência central?

A mediana é preferida à média quando existem poucos valores extremos na distribuição, alguns valores são indeterminados, ou há uma distribuição aberta, ou os dados são medidos em uma escala ordinal.189

A moda é preferida quando os dados são medidos em uma escala nominal.189

A média geométrica é preferida quando os dados são medidos em uma escala logarítmica.189

17.6 Dispersão

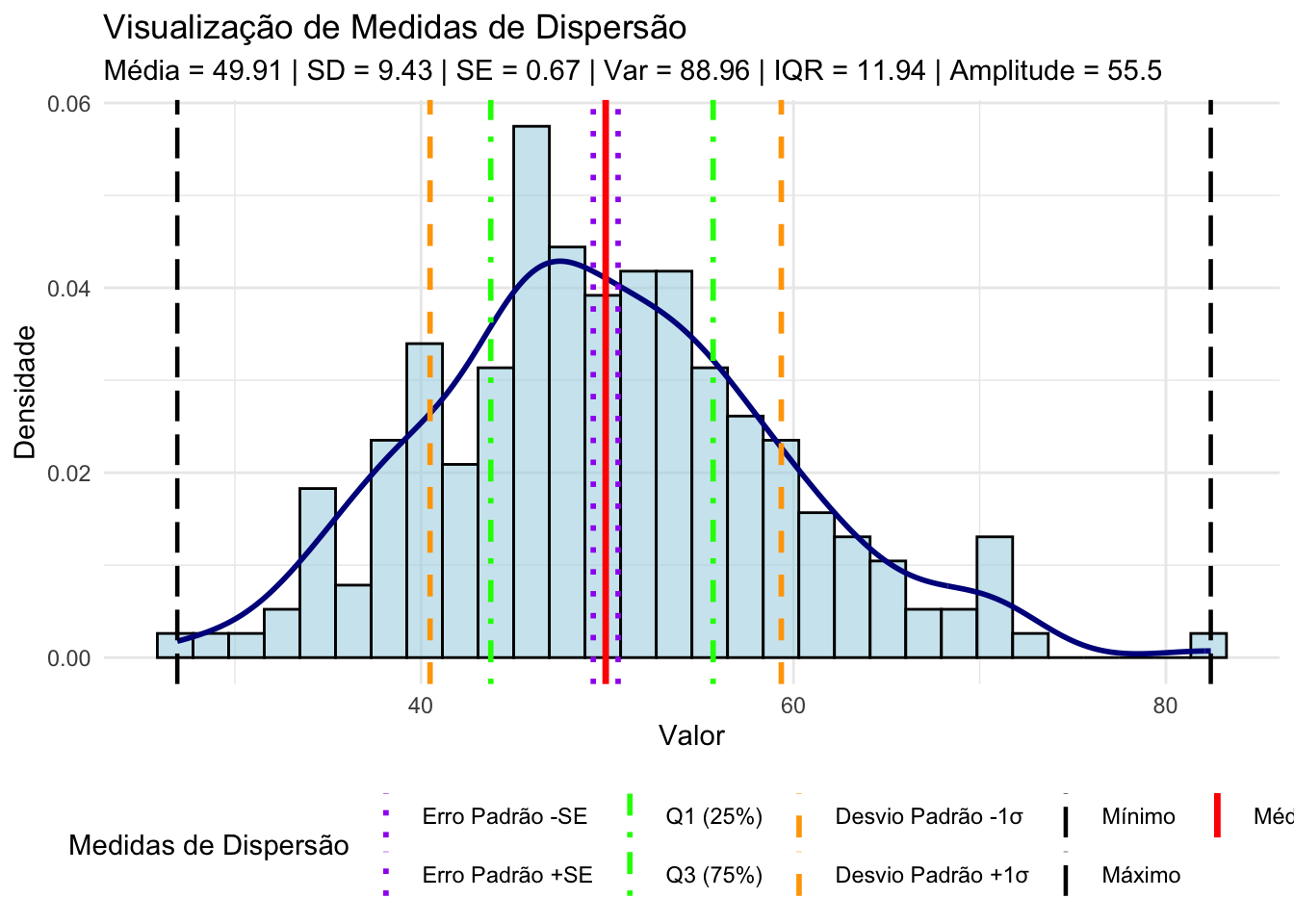

17.6.1 Que parâmetros de dispersão podem ser estimados?

\[\begin{equation} \tag{17.13} s^2 = \frac{\sum_{i=1}^{n} (x_i - \bar{x})^2}{n-1} \end{equation}\]

\[\begin{equation} \tag{17.14} s = \sqrt{\frac{\sum_{i=1}^{n} (x_i - \bar{x})^2}{n-1}} \end{equation}\]

\[\begin{equation} \tag{17.15} A = x_{\max} - x_{\min} \end{equation}\]

\[\begin{equation} \tag{17.16} IQR = Q_3 - Q_1 \end{equation}\]

Figura 17.15: Parâmetros de dispersão em distribuições normais.

O pacote stats134 fornece a função confint para calcular o intervalo de confiança em um nível de significância \(\alpha\).

17.6.2 Como escolher o parâmetro de dispersão?

Desvio-padrão é apropriado quando a média é utilizada como parâmetro de tendência central em distribuições simétricas.190

Amplitude ou intervalo interquartil são apropriadas para variáveis ordinais ou distribuições assimétricas.190

17.6.3 O que é a correção de Bessel para variância?

Correção de Bessel é um ajuste feito no denominador da fórmula de variância da amostra — ou seja, o número de graus de liberdade — para evitar que a variância amostral seja menor do que a variância populacional.191

A correção de Bessel é feita subtraindo-se 1 do número de observações da amostra, ou seja, \(n - 1\) (17.17).191

\[\begin{equation} \tag{17.17} s^2 = \frac{\sum_{i=1}^{n} (x_i - \bar{x})^2}{n-1} \end{equation}\]

17.6.4 Por que a correção de Bessel para variância é importante?

A correção de Bessel é importante porque a variância amostral tende a ser menor do que a variância populacional, especialmente em amostras pequenas.191

A correção de Bessel ajuda a garantir que a variância amostral seja uma estimativa mais precisa da variância populacional, o que é fundamental para a validade dos testes estatísticos e das inferências feitas a partir da amostra.191

17.7 Proporção

17.7.1 Que parâmetros de proporção podem ser estimados?

\[\begin{equation} \tag{17.18} f_i = n_i \end{equation}\]

\[\begin{equation} \tag{17.19} fr_i = \frac{n_i}{N} \end{equation}\]

- Percentil (17.20), onde \(k\) é o percentil desejado (0 a 100) e \(n\) é o número total de observações na amostra.112,183,185

\[\begin{equation} \tag{17.20} P_k = x_{\left(\frac{k}{100} \cdot (n+1)\right)} \end{equation}\]

Quantil: é o ponto de corte que define a divisão da amostra em grupos de tamanhos iguais. Portanto, não se referem aos grupos em si, mas aos valores que os dividem:185

Tercil: 2 valores que dividem a amostra em 3 grupos de tamanhos iguais.185

Quartil: 3 valores que dividem a amostra em 4 grupos de tamanhos iguais.185

Quintil: 4 valores que dividem a amostra em 5 grupos de tamanhos iguais.185

Decil: 9 valores que dividem a amostra em 10 grupos de tamanhos iguais.185

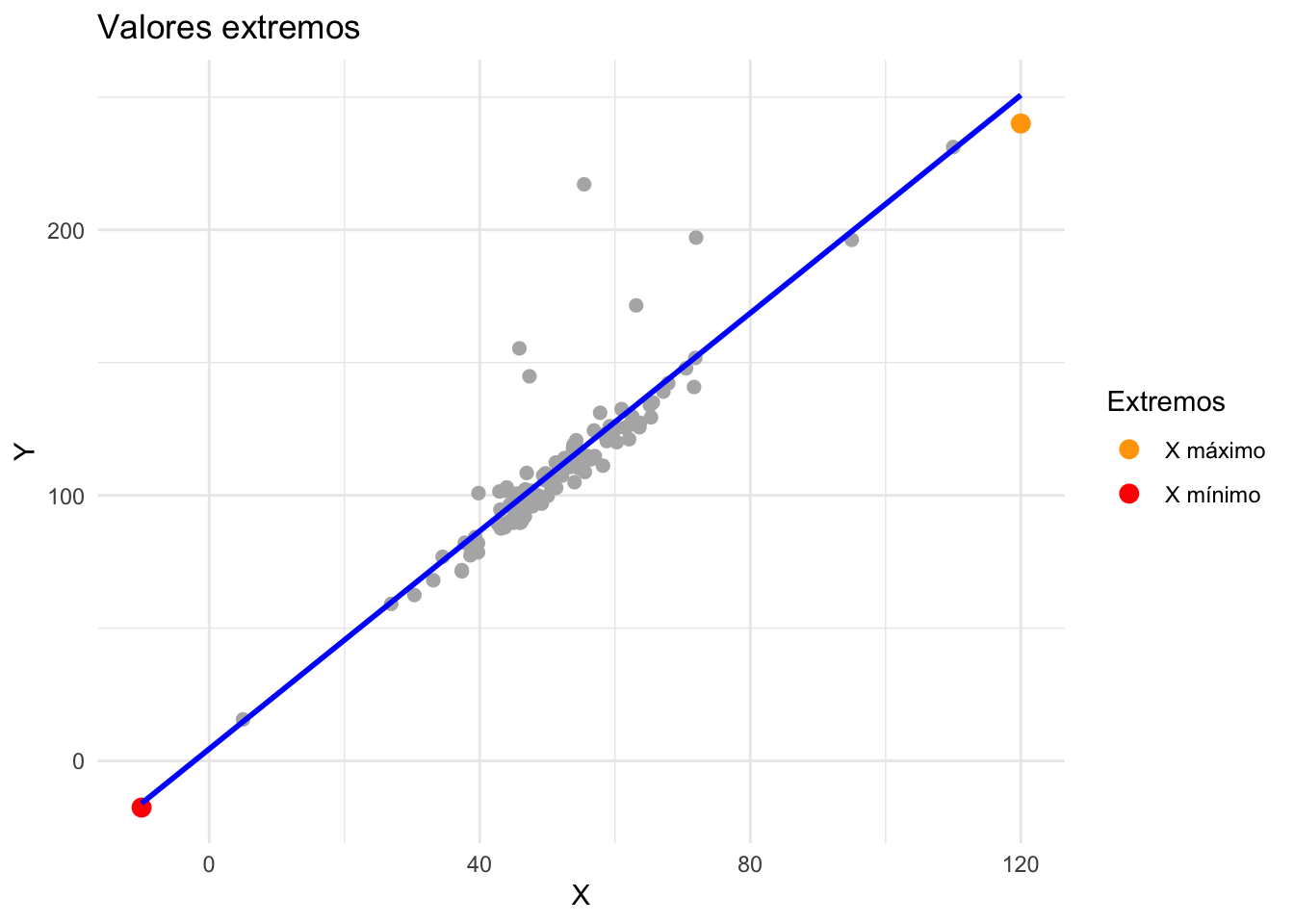

17.8 Extremos

17.8.1 O que são valores extremos?

- Valores extremos podem constituir valores legítimos ou ilegítimos de uma distribuição.192

17.9 Distribuição

17.9.1 Que parâmetros de distribuição podem ser estimados?

\[\begin{equation} \tag{17.23} \gamma_1 = \frac{\frac{1}{n}\sum_{i=1}^{n}(x_i - \bar{x})^3}{\left(\frac{1}{n}\sum_{i=1}^{n}(x_i - \bar{x})^2\right)^{3/2}} \end{equation}\]

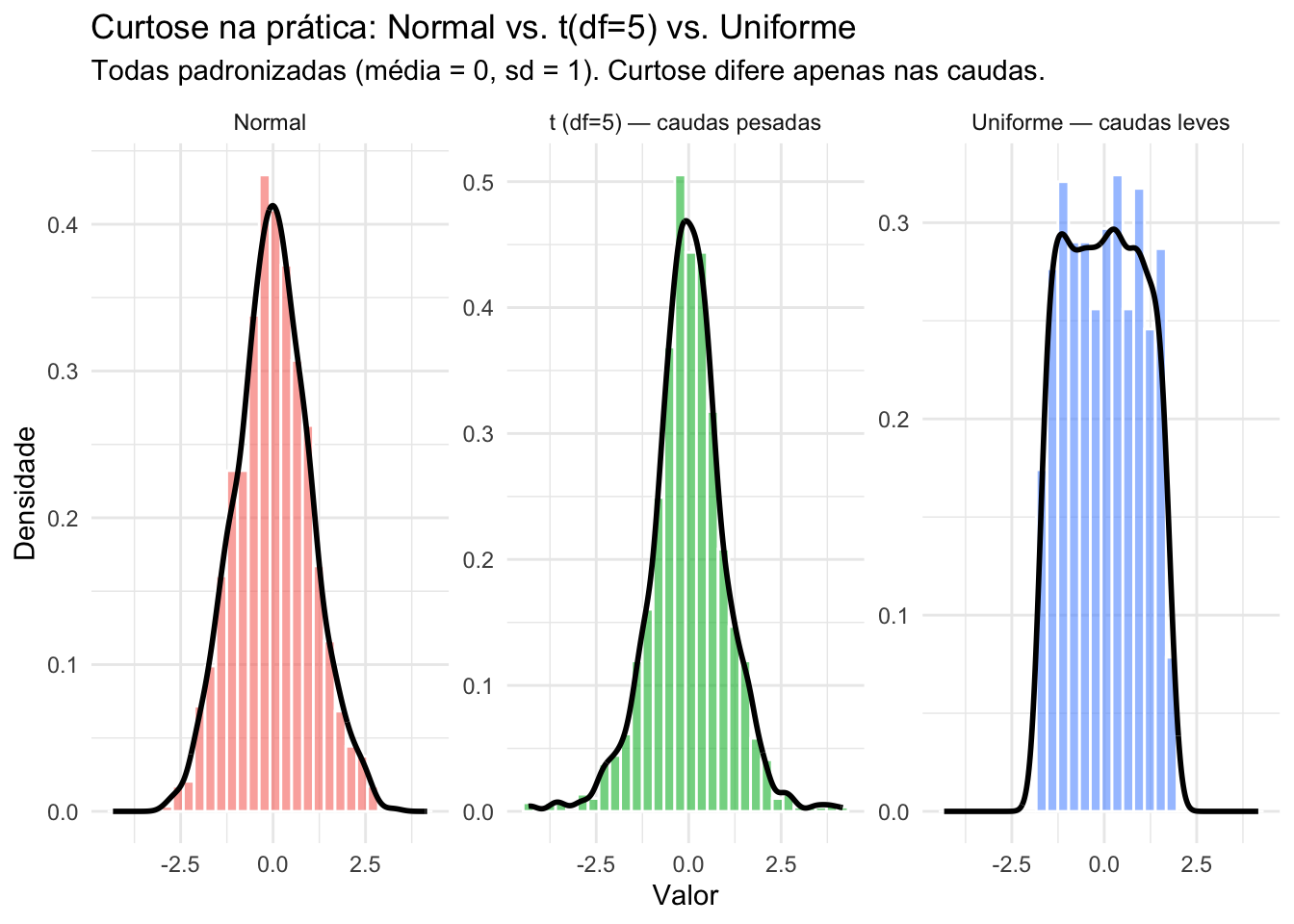

\[\begin{equation} \tag{17.24} \gamma_2 = \frac{\frac{1}{n}\sum_{i=1}^{n}(x_i - \bar{x})^4}{\left(\frac{1}{n}\sum_{i=1}^{n}(x_i - \bar{x})^2\right)^{2}} \end{equation}\]

\[\begin{equation} \tag{17.25} \kappa = \gamma_2 - 3 \end{equation}\]

Figura 17.17: Parâmetros de distribuição: Assimetria e Curtose.

Figura 17.18: Parâmetros de distribuição: Curtose em distribuições simétricas (normal vs. uniforme).

17.10 Robustez em medidas de localização

17.10.1 O que é ponto de quebra?

- É a menor proporção de contaminação que pode levar o estimador a resultados arbitrariamente errados; quanto maior, mais robusto.193

17.10.2 Por que a média não é robusta?

- Porque tem ponto de quebra \(~0%\) e função influência não limitada; um único outlier pode distorcer a média arbitrariamente.193

17.10.3 Qual a alternativa robusta para localização?

- Mediana, com \(~50%\) de ponto de quebra e função influência limitada.193

17.10.4 Como estimar escala de forma robusta?

- Median Absolute Deviation (MAD) (??), com correção 1,483 para normalidade, com \(~50%\) de ponto de quebra.193

\[\begin{equation} \tag{17.22} MAD = 1.483 \cdot \text{median}(|x_i - \text{median}(x)|) \end{equation}\]

\[\begin{equation} \tag{17.26} Qn = 2.2219 \cdot \text{first quartile}(|x_i - x_j|; i < j) \end{equation}\]

- O intervalo interquartil (\(IQR\)) (17.16) é robusto, com ponto de quebra \(~25%\), sendo simples de interpretar e útil em boxplots.193

17.11 Parâmetros robustos

17.11.1 O que são parâmetros robustos?

- Parâmetros robustos são medidas de posição e dispersão que permanecem estáveis mesmo na presença de valores discrepantes.194

17.11.2 Que parâmetros robustos podem ser estimados?

Mediana em vez da média aritmética, pois é menos sensível a valores extremos.194

Median Absolute Deviation (MAD) em vez do desvio-padrão \(\sigma\), que pode ser escalonado por 1,483 para comparabilidade.194

\(Qn\) e \(Sn\) como estimadores alternativos de dispersão robusta.194

Média e variância Winsorizadas como opções intermediárias, reduzindo a influência dos outliers.194

17.11.3 Por que utilizar parâmetros robustos?

Parâmetros robustos garantem maior confiabilidade quando os dados não seguem a normalidade ou apresentam contaminação por outliers.194

Parâmetros robustos permitem análises mais estáveis em estudos exploratórios, evitando decisões equivocadas sobre variabilidade ou tendência central.194

Ferreira, Arthur de Sá. Ciência com R: Perguntas e respostas para pesquisadores e analistas de dados. Rio de Janeiro: 1a edição,